Die wichtigsten Fehler beim A/B-Testen auf der Website eines Online-Shops und wie man sie vermeidet

-

Römisches Revun

Copywriter Elbuz

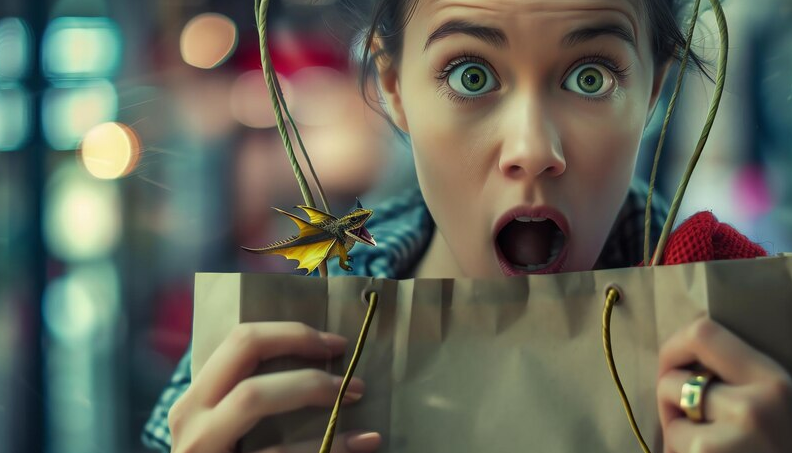

Wenn es um A/B-Tests eines Online-Shops geht, scheint alles einfach zu sein: Wir teilen die Benutzer in zwei Gruppen ein, zeigen verschiedene Versionen der Seite und vergleichen sie . Was aber, wenn eine Kleinigkeit dazu führt, dass all Ihre Bemühungen den Bach runtergehen? Stellen Sie sich vor, die Macher eines erfolgreichen Online-Shops führten einen solchen Test durch und änderten dabei nur eine Schaltfläche. Ja, nur eine, aber das Ergebnis war das Gegenteil von dem, was erwartet wurde. Welche Fehler haben sie und Tausende andere Unternehmen nicht berücksichtigt? Versuchen wir es gemeinsam herauszufinden.

Glossar

🎯 A/B-Tests: Bewertungsmethode Änderungen an der Website, indem zwei Versionen der Seite (A und B) erstellt und deren Wirksamkeit für Benutzer gemessen werden.

❌ Split-Tests: Sorte A/ B Tests, bei denen der Datenverkehr in gleiche Segmente aufgeteilt und an verschiedene Versionen der Seite gesendet wird, um Änderungen zu bewerten.

🕒 Testzeitraum: Zeit, in der A /B-Tests werden durchgeführt, um genügend Daten für die Analyse zu sammeln.

🎯 Hypothese: Eine zu prüfende Annahme im Prozess des A/B-Tests, bei dem davon ausgegangen wird, dass bestimmte Änderungen zu verbesserten Kennzahlen führen.

🎨 Design: Visuelle Komponente der Website , einschließlich Schriftarten, Farben, Bilder und Navigationselemente.

📈 Oberflächenmetriken: Metriken der obersten Ebene B. Klicks und Seitenaufrufe, die nicht immer das tatsächliche Nutzerverhalten widerspiegeln.

👥 Fokusgruppen: Bestimmte Zielgruppensegmente ausgewählt an Tests teilzunehmen, um relevante Daten zu erhalten.

📉 Wenig Verkehr: Die Situation, in der die Die Website hat nicht genügend Besucher, um einen statistisch signifikanten A/B-Test durchzuführen.

📊 Quantitative Daten: Digitale Indikatoren wie z Engagement, Umsatz und Zeit vor Ort werden zur Analyse der Testergebnisse verwendet.

📄 Unbedeutende Seiten: Site-Seiten, die dies tun spielen keine Schlüsselrolle in der User Journey oder den Geschäftszielen.

🔄 Gleichzeitiges Testen: Durchführung mehrerer A/ Führen Sie gleichzeitig B-Tests durch, was zu gemischten Ergebnissen und falschen Schlussfolgerungen führen kann.

🔍 Details: Kleine, aber wichtige Elemente, B. Schaltflächenformulierung, Elementplatzierung und kleinere visuelle Änderungen, die sich auf das Benutzererlebnis auswirken.

⚙️ Analyseeinstellungen: Konfiguration des Erfassungstools und Interpretation von Testdaten.

📚 Ergebnisdatenbank: Systematisierte Datenerfassung und Erkenntnisse aus früheren Tests werden zur Unterstützung zukünftiger Entscheidungen herangezogen.

🔄 Einzelner Bereich: Konzentrieren Sie sich auf einen Teil Website oder ein Element und vernachlässigt andere Verbesserungsmöglichkeiten.

🗺️ Segmente: Aufteilen von Benutzern in Gruppen nach bestimmte Merkmale für eine genauere Analyse der Testergebnisse.

🔄 Hypothesenversionen: Verschiedene Ansätze und Optionen Änderungen, die getestet werden, um eine Hypothese zu bestätigen oder zu widerlegen.

🚀 Großflächige Änderungen: Signifikante Änderungen auf die Website bezogen auf Design, Funktionalität oder Struktur, die ein hohes Risiko bergen.

Fehler Nr. 1 – Split-Tests ablehnen überhaupt oder unregelmäßig durchführen

Ich kann mit Sicherheit sagen, dass einer der schwerwiegendsten Fehler bei der Durchführung von A/B-Tests auf der Website eines Online-Shops die Weigerung ist, Split-Tests durchzuführen alle oder ihre unregelmäßige Umsetzung. Ich habe die Erfahrung gemacht, dass viele Online-Shop-Besitzer die Durchführung ständiger Tests als Zeit- und Ressourcenverschwendung betrachten. Ich kann Ihnen jedoch versichern, dass regelmäßige A/B-Tests der Schlüssel zur kontinuierlichen Verbesserung des Benutzererlebnisses und zur Steigerung der Conversions sind.

Beispiele nicht bestandener Tests aus meiner Praxis

📉 Einer der Kunden beschloss, A/B-Tests nur einmal durchzuführen, da er glaubte, dass dies ausreichen würde, um die gewünschten Ergebnisse zu erzielen. Leider zeigten die Testergebnisse ohne regelmäßige Analyse und Umsetzung neuer Ideen keine nachhaltige Wirkung und die Konvertierung erreichte bald wieder das ursprüngliche Niveau.

📉 Ein weiteres Beispiel aus meiner Praxis ist ein Unternehmen, das unregelmäßig und ohne klaren Plan Tests durchführte. Die Ergebnisse solcher Tests waren chaotisch und führten nicht immer zu Verbesserungen.

Wie man Fehler vermeidet und Ergebnisse verbessert

👨🔬 Ich glaube, dass das richtig ist Der Ansatz wird einen systematischen Plan zur Durchführung von A/B-Tests implementieren. Regelmäßige Tests ermöglichen es Ihnen, Problembereiche rechtzeitig zu erkennen und sich an Marktveränderungen anzupassen.

📊 Ich ermutige Sie, sich mit dem strukturierten Testansatz von zu befassen. Dazu gehört:

- 📅 Planung – Erstellen Sie einen regelmäßigen Testplan und halten Sie sich daran .

- 🎯 Zielorientiert – Definieren Sie spezifische Ziele für jeden Test.

- 📝 Dokumentation – Zeichnen Sie alle Ergebnisse auf, damit Sie sie im Laufe der Zeit analysieren können.

- 📈 Analyse – regelmäßige Analyse der gewonnenen Daten und Anpassung der Strategie auf Basis der Erkenntnisse.

💡 Empfehlungen zur Verbesserung der Testhäufigkeit:

- 🤖 Automatisierung von Testprozessen mithilfe spezieller Tools.

- 📚 Schulen Sie Ihre Mitarbeiter, um eine Kultur der kontinuierlichen Verbesserung zu schaffen.

- 🛠 Verwendung von Metriken und KPIs zur Bewertung der Wirksamkeit jedes Tests.

Persönliches Beispiel eines erfolgreichen Tests

📈 Eines meiner Projekte zeigte beeindruckende Ergebnisse, danke zu regelmäßigen A/B-Tests. Wir haben verschiedene Variationen von Überschriften, Produktbeschreibungen, Bildern und sogar Schaltflächenfarben getestet. Dank eines systematischen Vorgehens konnten wir die Conversion innerhalb von sechs Monaten um 25 % steigern. Diese Erfahrung hat mich überzeugt, dass regelmäßige Tests der Schlüssel zum Erfolg sind.

Gesamt

Ich empfehle daher dringend, nicht den Fehler zu machen, A/B-Tests nicht oder nur unregelmäßig durchzuführen. Dieser Prozess erfordert Disziplin, aber die Ergebnisse sind es wert.

| Nützliche Praktiken | Vermeidbare Fehler |

|---|---|

| 📅 Regelmäßige Tests | ❌ Unregelmäßige Tests |

| 📊 Strukturierter Analyseansatz | ❌ Chaotisch und Planlos |

| 📝 Ergebnisse dokumentieren und analysieren | ❌ Analysemöglichkeiten ignorieren |

| 🎯 Spezifische Ziele definieren | ❌ Testen ohne Ziel oder Struktur |

Ich bin zuversichtlich, dass die Einhaltung dieser Richtlinien zu konsistenten und sinnvollen Verbesserungen Ihrer Online-Shop-Website führen wird.

Fehler Nr. 2 – Kurze Testphase

I Ich kann mit Sicherheit sagen, dass einer der Hauptfehler, der bei der Durchführung von A/B-Tests auf der Website eines Online-Shops vermieden werden sollte, die unzureichende Testdauer ist. In meiner Praxis bin ich auf Situationen gestoßen, in denen Unternehmer es eilig hatten, mit dem Testen aufzuhören, und sich die festgestellten Trends dadurch als falsch herausstellten.

Als ich einen der ersten Tests machte, entschied ich, dass zwei Wochen reichen würden genug für die Datenerfassung wird ausreichen. Die Ergebnisse schienen ermutigend und ich beeilte mich, eine Entscheidung zu treffen. Nach ein paar Wochen bemerkte ich jedoch, dass sich die Zahlen in die entgegengesetzte Richtung verändert hatten und die bisherigen Schlussfolgerungen sich als ungültig erwiesen. Seitdem bin ich davon überzeugt, dass die Ergebnisse umso genauer und zuverlässiger sein werden, je länger die Tests andauern. Dadurch können Sie saisonale Schwankungen, Wochenenden und Feiertage sowie zahlenmäßige Veränderungen im Publikum berücksichtigen.

Welchen Zeitraum sollte ich zum Testen wählen?

🔵 Idealerweise sollte die Mindestdauer des Tests 2-3 Wochen betragen. Dadurch ist es möglich, den gesamten Zyklus wichtiger Geschäftsprozesse abzudecken.

🔵 Es ist ratsam, große Feiertage und Hauptsaisonen zu meiden. In solchen Zeiträumen sind die Daten möglicherweise nicht repräsentativ und die Schlussfolgerungen möglicherweise unplausibel.

🔵 Berücksichtigen Sie externe Faktoren: Wechselkurse, Änderungen der Marktbedingungen und andere Umstände, die das Nutzerverhalten beeinflussen können.

Ein Beispiel aus meiner Erfahrung: Wir haben einmal vor Neujahr Tests auf der Website durchgeführt. Wir wollten herausfinden, welche Version der Landingpage zu mehr Verkäufen führen würde. Allerdings haben wir nicht berücksichtigt, dass die Feiertage zu einer hohen Einkaufsaktivität führen, die für den Rest des Jahres untypisch ist. Später, nach Ende der Feiertage, stellten wir fest, dass die Indikatoren stark zurückgingen und die zuvor gezogenen Schlussfolgerungen nutzlos waren. Seitdem habe ich immer auf die Saisonalität Rücksicht genommen und wichtige Urlaubszeiten gemieden.

Wann können Sie Schlussfolgerungen ziehen?

Es ist ratsam, Schlussfolgerungen zu ziehen, nachdem eine statistische Signifikanz von 95 % erreicht wurde. Dadurch erhalten Sie maximale Genauigkeit und Vertrauen in die Ergebnisse:

🟢 Legen Sie einen minimalen Testzeitraum fest.

🟢 Bewerten Sie die Ergebnisse, nachdem Sie alle Verkaufszyklen vollständig abgedeckt haben.

🟢 Parallel testen, unter Berücksichtigung saisonaler und wöchentlicher Schwankungen.

🟢 Achten Sie auf statistische Signifikanz und Geschäftsprozesszyklen.

Abschließend möchte ich die Bedeutung sorgfältiger Planung und sorgfältiger Datenanalyse betonen. Nur so können Sie Fehler vermeiden und genaue Ergebnisse erhalten, die zur Verbesserung Ihres Online-Shops beitragen.

Was zu tun und was nicht zu tun ist

| Nützliche Praktiken | Was Sie vermeiden sollten |

|---|---|

| 🟢 Langzeittest (2-3 Wochen) {{|110|.}} | 🔴 Kurze Testphase (weniger als eine Woche) |

| 🟢 Berücksichtigung externer Faktoren (Saisonalität, Feiertage) | 🔴 Ignorieren des Einflusses von Feiertagen und Hauptsaisonen |

| 🟢 Erreichen einer statistischen Signifikanz von 95 % | 🔴 Treffen von Entscheidungen bis zum Erreichen der statistischen Signifikanz |

| 🟢 Paralleles Testen | 🔴 Getrenntes Testen in verschiedenen Zeiträumen |

Ich empfehle dringend, diese Tipps zu berücksichtigen und Ihre Tests sorgfältig zu planen. Erfolgreiche A/B-Tests erfordern Geduld und Sorgfalt, aber die Ergebnisse werden sich um ein Vielfaches auszahlen.

Fehler Nr. 3 – Durchführung eines Tests ohne klare Hypothesen

Ich bin in der Vergangenheit immer wieder auf Situationen gestoßen, in denen A/B-Tests auf der Website eines Online-Shops ohne explizite und fundierte Hypothesen durchgeführt wurden. Dieser Ansatz kann zu Ineffizienz und Ressourcenverschwendung führen. Ich kann mit Sicherheit sagen, dass Stichprobentests selten zu aussagekräftigen Geschäftsergebnissen führen. Lassen Sie mich meine Gedanken und Erfahrungen teilen.

Warum sind Hypothesen wichtig?

Ich empfehle dringend, vor Beginn eines A/B-Tests konkrete Hypothesen zu formulieren. Eine Hypothese ist ein Ausgangspunkt, der definiert, was Sie verbessern werden und warum. Ich habe zum Beispiel einmal an einem Projekt teilgenommen, bei dem die Sichtbarkeit des „Kaufen“-Buttons auf der Hauptseite eines Online-Shops gering war, was die Konvertierung verringerte. Ich schlug vor, dass wir die Anzahl der Käufe erhöhen könnten, indem wir die Farbe und Position des Buttons ändern.

Wie baut man Hypothesen auf?

Um eine Hypothese aufzustellen, befolge ich immer ein paar wichtige Schritte:

🔍 Was ist das Problem? – Zunächst einmal definiere ich das Problem klar. In unserem Fall war es eine geringe Conversion.

🔍 Wo liegt das Problem? – Als nächstes ist es wichtig zu verstehen, in welcher Phase des Prozesses sich das Problem manifestiert. In diesem Beispiel war es die Hauptseite.

🔍 Ursache des Problems? – Die Ermittlung der Ursache des Problems ist der Schlüssel. Wir stellten fest, dass die Schaltfläche „Kaufen“ schwer zu erkennen war.

🔍 Lösungen? – Ich biete mögliche Lösungen an. In unserem Beispiel ändern Sie die Farbe und Platzierung der Schaltfläche.

🔍 Welche Elemente sollte ich ändern? – Es ist wichtig, klar zu definieren, welche Elemente geändert werden, um das Problem zu lösen.

Beispiel aus meiner Praxis

Zur Veranschaulichung gebe ich ein konkretes Beispiel. Einer unserer Großkunden kam mit einem Problem mit einem geringen Prozentsatz an Newsletter-Abonnements auf mich zu. Wir gingen davon aus, dass das Problem ein unklarer Aufruf zum Handeln war. Nachdem wir einen klaren und helleren Text für das Abonnementformular formuliert hatten, begannen wir mit den Tests. Nach drei Wochen verdoppelte sich die Anzahl der Abonnements.

Diese erfolgreiche Erfahrung hat mir gezeigt, wie wichtig es ist, klare Hypothesen zu haben. Alle Änderungen sollten auf Fakten und Beobachtungen basieren, nicht auf Vermutungen.

„Formulieren Sie für erfolgreiche A/B-Tests immer klare, vernünftige Hypothesen.“ – Meine Hauptregel.

Zusammenfassung und Empfehlungen

Ich bin sicher, dass das Fehlen spezifischer Hypothesen einer der Gründe dafür ist die häufigsten Fehler beim A/B-Testing. Bevor ich mit einem Test beginne, empfehle ich dringend:

📝 Formulieren Sie klare Hypothesen.

📊 Basieren Sie sie auf Fakten und Daten.

🔄 Identifizieren Sie eindeutig die Elemente, die geändert werden.

Führen Sie Tests über einen ausreichend langen Zeitraum durch, um zuverlässige Ergebnisse zu erhalten.

| Nützliche Praktiken | Vermeidbare Fehler |

|---|---|

| Klare Hypothesen formulieren | Test ohne Hypothesen |

| Basieren Sie Methoden auf Fakten. | Handeln Sie zufällig. |

| Definieren Sie klar Elemente | Änderungen über den gesamten Prozess strecken |

| Übertragen langwierige Tests durchführen | Kurzzeittests durchführen |

Ich rate allen digitalen Vermarktern dringend, auf die richtige Formulierung von Hypothesen für effektives und effizientes A/B-Testen zu achten.

Fehler Nr. 4 – Überbetonung des Designs

Von Aus meiner Erfahrung kann ich mit Sicherheit sagen, dass einer der häufigsten Fehler bei der Durchführung von A/B-Tests auf der Website eines Online-Shops darin besteht, zu viel Wert auf das Design zu legen. Unternehmer konzentrieren all ihre Bemühungen oft auf die Änderung des visuellen Designs der Seite und vergessen dabei, dass der Schlüsselaspekt die Steigerung der Konversionsrate ist.

Als ich A/B-Tests für eines der Projekte durchführte, haben wir zuerst konzentrierte sich auf die Änderung des Erscheinungsbilds der Website: Farben, Schriftarten, Symbole. Wir erwarteten, dass dies zu einem beeindruckenden Umsatzwachstum führen würde. Die Ergebnisse blieben jedoch weit hinter unseren Erwartungen zurück – die Conversion stieg nur um 2 %. Dies brachte mich zu dem Schluss, dass Design nicht immer der entscheidende Faktor ist.

Nach der Analyse der Daten haben wir beschlossen, unseren Ansatz zu ändern und auf kleinere, aber wichtige Details zu achten:

✍️ Verkaufen Überschriften

Ich glaube, dass das Ändern von Titeln ein wichtiges Element der Optimierung ist. Überschriften sollten hell, interessant und für die Bedürfnisse des Benutzers relevant sein. Anstelle von „Unsere besten Angebote“ haben wir beispielsweise die Überschrift in „Exklusive Rabatte nur heute – lassen Sie sich die Chance nicht entgehen!“ geändert. Dies erregte die Aufmerksamkeit der Nutzer und steigerte ihr Interesse an dem Angebot deutlich.

📄 Textkörper

Körpertext sollte nicht nur eindeutig, sondern auch spezifisch sein. Anstelle allgemeiner Produktaussagen empfehle ich die Verwendung von Beschreibungen, die gezielt auf die Kundenbedürfnisse eingehen. Zum Beispiel: „Unsere Sneaker sind dank ihrer leichten und bequemen Sohle ideal für lange Spaziergänge und Sport.“

💡 CTA-Buttons

Klare und verständliche Handlungsaufforderungen sind der Schlüssel. Ich bin davon überzeugt, dass Schaltflächen mit Texten wie „Jetzt kaufen“ oder „Rabatt erhalten“ besser funktionieren als nur „Weiter“ oder „Weitere Details“. In meinem Fall steigerte die Änderung des Textes der Schaltflächen die Conversion um 15 %.

.gif)

🗺️ Position der Elemente

{{|2 |.}} Auch die Anordnung der Elemente auf der Seite spielt eine wichtige Rolle. Ich habe festgestellt, dass das Verschieben von CTA-Buttons weiter oben auf der Seite das Benutzererlebnis und damit die Konversionsraten verbessert. Beispielsweise haben wir „Jetzt kaufen“-Buttons neben Produktbildern und deren Kurzbeschreibungen platziert.🔍 Beispiele für erfolgreiches Testen

Bei einem der Projekte haben wir zunächst nur das Design geändert und keine erhalten signifikanter Effekt. Später konnten wir durch die Anwendung der oben beschriebenen Methoden einen Anstieg der Conversions um 20 % feststellen. Dies zeigte, dass die richtige Betonung der wichtigen Elemente einer Seite greifbare Ergebnisse bringt.

„Bei der On-Page-Optimierung geht es nicht nur um Design. Es geht darum, die Bedürfnisse des Benutzers zu erfüllen und sein Erlebnis zu verbessern.“ – Richard Newton, Autor von fünf erfolgreichen Wirtschaftsbüchern, darunter „Projektmanagement von A bis Z“.

Empfehlungstabelle

| Was zu tun ist | Was Sie nicht tun sollten |

|---|---|

| 📑 Verwenden Sie verkaufsstarke Schlagzeilen | ❌ Verlassen Sie sich nur auf Seitendesignänderungen |

| ✍️ Schreiben Sie interessant und einzigartig Textkörper | ❌ Text, der mit Benutzeranfragen übereinstimmt, ignorieren |

| 📢 Installieren Sie klare und verständliche CTA-Buttons | ❌ Buttons unten auf der Seite ausblenden |

| 🏷️ Optimieren Sie die Platzierung von Elementen | ❌ Versuchen Sie, nur die visuellen Komponenten zu ändern |

Daher rate ich Ihnen dringend, sich bei der Durchführung von A/B-Tests auf diese Aspekte zu konzentrieren. Berücksichtigen Sie die kleineren, aber wichtigen Details, die Ihre Conversion-Raten erheblich verbessern können.

Fehler Nr. 5 – Nach oberflächlichen Maßstäben jagen

Messen Die Wirksamkeit eines Testupdates erfordert eine sorgfältige und durchdachte Vorgehensweise. Ich möchte meine persönlichen Erfahrungen teilen, die zeigen, wie fehlerhafte Indikatoren zu falschen Schlussfolgerungen führen können. Lassen Sie mich Ihnen einige Fälle aus meiner Praxis vorstellen.

Es gab Zeiten, in denen mein Team und ich einen spürbaren Anstieg der Likes und Likes bemerkten Reposts in sozialen Netzwerken nach der Einführung eines neuen Produktseitendesigns. Dies schien ein Erfolg zu sein, aber als wir mit der Analyse der tatsächlichen Konvertierung begannen, wurde klar, dass die Anzahl der Verkäufe auf dem gleichen Niveau blieb. Dann wurde mir klar, dass Indikatoren wie Likes und Reposts nicht immer mit dem Umsatzwachstum korrelieren.

Beispiele und Beweise meiner Aussagen

🟢 Beispiel 1: Erhöhung der Anzahl der Besuche auf der Website.

Eines Tages führten unsere Tests zu einem Anstieg des Website-Verkehrs. Auf den ersten Blick schien dies ein tolles Ergebnis zu sein, aber wenn man genauer hinschaut, blieb der Anstieg der Bestellungen vernachlässigbar. Dadurch wurde mir klar, dass ein erhöhter Website-Verkehr keine Garantie für höhere Umsätze ist.

🟢 Beispiel 2: Steigerung der Anzahl der Newsletter-Abonnenten.

Ein weiterer Fall aus meiner Praxis ist ein Newsletter, nach dem die Abonnementstatistik deutlich anstieg. Die Analyse ergab jedoch, dass die tatsächliche Umwandlung neuer Abonnenten in echte Kunden minimal war. Dies hat mir einmal mehr gezeigt, dass man diesem Indikator keine allzu große Bedeutung beimessen sollte.

Wenn Sie diese Fehler machen, können Sie Zeit und Ressourcen mit der Optimierung von Parametern verschwenden, die Ihrem Unternehmen nicht wirklich nützen. Es ist wichtig, sich auf die Indikatoren zu konzentrieren, die einen direkten Einfluss auf den Umsatz und den Gewinn des Unternehmens haben. Ich empfehle immer, nicht nur oberflächliche Kennzahlen zu berücksichtigen, sondern auch die tatsächlichen Finanzergebnisse zu berücksichtigen.

Wie vermeidet man Fehler bei der Messung von Oberflächenindikatoren?

🔍 Tipp 1: Identifizieren Sie vor dem Testen wichtige Leistungsindikatoren (KPIs).

Ich möchte Sie ermutigen, sich zunächst darüber im Klaren zu sein, welche Kennzahlen für Ihr Unternehmen von grundlegender Bedeutung sind. Bei einem Online-Shop könnten dies Conversion und Einkommen sein. Andere Indikatoren sollten zwar nützlich sein, aber im Hintergrund bleiben.

🔍 Tipp 2: Analysieren Sie Daten ganzheitlich.

Ziehen Sie keine voreiligen Schlüsse, wenn Sie einen Anstieg bei einem der Indikatoren feststellen. Vergleichen Sie es mit anderen Metriken und folgen Sie der allgemeinen Logik der Änderungen. Beispielsweise ist eine Steigerung der Like-Zahlen in sozialen Netzwerken gut, wichtiger ist jedoch zu verstehen, ob dies zu einer Steigerung der Bestellungen geführt hat.

🔍 Tipp 3: Berücksichtigen Sie den Einfluss von Saisonalität und externen Faktoren.

Ich habe oft gesehen, dass Messwerte durch Faktoren wie Feiertage oder Werbeaktionen beeinflusst wurden. Berücksichtigen Sie stets den Kontext von Änderungen, um falsche Schlussfolgerungen zu vermeiden.

Blockieren -Diagramm zur Verbesserung des Messansatzes:

- 💡 Ziele und KPIs klären.

- 💡 Analysieren Sie gemeinsam Kennzahlen.

- 💡 Betrachten Sie den externen Kontext.

Ich bin überzeugt, dass der richtige Ansatz zur Analyse von Indikatoren es Ihnen ermöglicht, die zuverlässigsten Ergebnisse zu erzielen und darauf zu achten diejenigen Aspekte, die für das Geschäft wirklich wichtig sind. Die Umsetzung dieses Prinzips hat unsere A/B-Testergebnisse erheblich verbessert, und ich bin zuversichtlich, dass die Befolgung dieser Tipps Ihnen dabei helfen wird, häufige Fehler zu vermeiden.

Fehler Nr. 6 – Auswahl irrelevanter Fokusgruppen

Ein häufiger Fehler bei der Durchführung von A/B-Tests in Online-Shops besteht darin, irrelevante Fokusgruppen auszuwählen, um Änderungen zu testen. Um die Ernsthaftigkeit des Problems zu verdeutlichen, werde ich meine Geschichte erzählen.

Ich habe kürzlich mit einem Online-Shop zusammengearbeitet, der eine aktualisierte Warenkorb-Oberfläche testen wollte. Die Führungskräfte des Unternehmens beschlossen, keine Zeit und kein Geld für die Gewinnung eines neuen Publikums zu verschwenden und nur ihre Mitarbeiter und deren Bekannte für die Tests heranzuziehen. Es scheint logisch: Sie alle kaufen oft Waren in diesem Geschäft und kennen alle Nuancen. Doch das Ergebnis war weit von der Realität entfernt.

Probleme beim Testen bei Freunden:

{{|. 6|}}Nach der Analyse der Testergebnisse fiel mir auf, dass es eine erhebliche Diskrepanz zwischen den Testergebnissen und den Reaktionen echter Kunden gab. Dies wurde nach der Umsetzung der Änderungen deutlich, als die Konversionsraten sanken und die Zahl der Beschwerden zunahm.

So verhindern Sie diesen Fehler

Ich empfehle, die folgenden Schritte für eine erfolgreiche Fokusgruppe in Betracht zu ziehen Auswahl:

- Erstellen eines genauen Porträts der Zielgruppe: Vorher Insgesamt erstelle ich immer ein detailliertes Porträt eines potenziellen Käufers unter Berücksichtigung demografischer und psychografischer Merkmale.

- Verwendung von Drittanbieterplattformen zur Rekrutierung von Benutzern: Ich rekrutiere Teilnehmer häufig über spezielle Plattformen wie UserTesting oder UsabilityHub. Dies hilft mir, Meinungen von Leuten einzuholen, die mit den internen Prozessen des Unternehmens nicht vertraut sind.

- Datenerfassung und -analyse: Führen Sie Untersuchungen an einer großen Stichprobe durch und analysieren Sie die Ergebnisse, um objektive Daten zu erhalten.

Beispiel für einen erfolgreichen Test:

Aufgrund meiner Fehler habe ich den Test mit den oben beschriebenen Methoden erneut durchgeführt. Mithilfe einer Drittanbieterplattform habe ich eine Fokusgruppe aus 1.000 neuen Nutzern zusammengestellt, die der Zielgruppe entsprachen. Die Ergebnisse waren genauer und nützlicher – Warenkorbänderungen führten zu einer Steigerung der Conversions um 15 % und dies war bereits in den ersten Wochen nach der Implementierung deutlich sichtbar.

„Tests mit zufälligen Benutzern lieferten uns zuverlässigere Daten. Dies hat uns geholfen, Vorurteile zu vermeiden und die Qualität des Produkts zu verbessern.“ – Igor Volyunets, Marketingmanager bei der Firma ALLO.

Hilfreiche Tipps:

- ✔ Führen Sie Tests für verschiedene Segmente der Zielgruppe durch {{|7|.}} ✔ Nutzen Sie professionelle Plattformen, um Teilnehmer zu gewinnen

- ✔ Analysieren Sie die Ergebnisse Gemeinsame Trends identifizieren und Anomalien beseitigen

Vorteile und Risiken:

| Aktion | Hilfreich | Nicht empfohlen |

|---|---|---|

| Auswahl realer Vertreter der Zielgruppe | Erhöht die Objektivität | - |

| Verwendung des inneren Kreises | - | Erhöht den Bias |

| Nutzung von Plattformen Dritter | Bietet unterschiedliche Meinungen | {{|. 20|}} Erfordert zusätzliche Kosten

Folgen Wenn Sie diese Richtlinien befolgen, bin ich sicher, dass Ihre A/B-Tests genauer und nützlicher für Ihren Online-Shop werden.

Fehler Nr. 7 – Tests bei geringem Verkehrsaufkommen

Aufgrund meiner Erfahrung bei der Durchführung von A/B-Tests in verschiedenen Online-Shops kann ich mit Sicherheit sagen, dass das Testen unter Bedingungen mit geringem Datenverkehr einer der häufigsten Fehler ist. Ein Beispiel für diese Situation ist ein Projekt, an dem ich vor einigen Jahren gearbeitet habe, bei dem ein Online-Shop beschloss, eine neue Version einer Produktseite zu testen, während die Anzahl der Besuche erheblich begrenzt war.

📉 Warum dieser Ansatz nicht funktioniert :

- Unzureichende Daten. Wenn der Site-Verkehr gering ist, ist die erfasste Stichprobe zu klein, um die Hypothesen statistisch signifikant zu testen. Daher können die erhaltenen Daten anekdotischer Natur sein und möglicherweise nicht die tatsächlichen Auswirkungen der Änderungen widerspiegeln.

- Lange Testzeit. Wenn der Datenverkehr gering ist, können sich die Tests über Monate hinziehen, was die Entscheidungsfindung und die Umsetzung nützlicher Verbesserungen verlangsamt.

- Ungerechtfertigte Ausgaben. Der Versuch, Tests unter solchen Bedingungen durchzuführen, führt häufig zu verschwendeten Kosten, da Geld und Zeit für einen Test verschwendet werden, dessen Ergebnisse nicht mit völliger Sicherheit verwendet werden können.

„Einen A/B-Test bei wenig Verkehr durchzuführen, ist wie der Versuch, Musik auf einer lauten Straße zu hören: Das gibt es.“ viel Lärm und wenig Klarheit. — Online-Analytics-Experte bei Prom, Ilya Vdovin.

🥇 Best Practices zur Vermeidung dieses Fehlers:

- Konzentrieren Sie sich auf stark frequentierte Seiten. Ich empfehle dringend, sich auf die Seiten mit dem höchsten Traffic zu konzentrieren, z. B. die Startseite oder Produktkategorieseiten. Dies liefert genügend Daten, um einen aussagekräftigen A/B-Test durchzuführen.

- Verwendung von Mikrokonvertierungen. Wenn die Hauptkonversionsrate zu niedrig ist, empfehle ich die Verwendung von Mikrokonvertierungen, z. B. Klicks auf bestimmte Schaltflächen oder Hinzufügen von Artikeln zum Warenkorb. Auf diese Weise können Sie schnell die erforderlichen Statistiken sammeln.

- Konsolidierung des Traffics aus mehreren Quellen. In einem der von mir geleiteten Projekte haben wir Daten von mehreren unserer Markenseiten kombiniert, um den Traffic zu steigern. Danach wurden die Tests aussagekräftiger und interpretierbarer.

Einige spezifische Tipps:

- Ich glaube, dass die richtige Lösung darin besteht, Pilottests durchzuführen, die sich auf die am häufigsten besuchten Seiten konzentrieren.

- Ich glaube, dass Kennzahlen genau überwacht und korrekt gemessen werden müssen, um eine genaue Bewertung der Ergebnisse zu erhalten.

- Ich finde es nützlich, Hypothesen regelmäßig zu überprüfen und sie an die aktuellen Bedingungen und die Verkehrsdynamik anzupassen.

Tabelle : Was ist zu tun und was zu vermeiden, wenn A/B-Tests bei geringem Datenverkehr durchgeführt werden

| Nützliche Maßnahmen | Zu vermeidende Maßnahmen |

|---|---|

| ✅ Konzentrieren Sie sich auf stark frequentierte Seiten | ❌ Testen Sie Seiten mit geringem Traffic |

| ✅ Verwendung von Mikrokonvertierungen | ❌ Ignorieren von Zwischenmetriken |

| ✅ Traffic-Aggregation zur Vergrößerung der Stichprobe | ❌ Langwierige Tests mit unsicheren Ergebnissen |

| ✅ Regelmäßige Überarbeitung der Hypothesen | ❌ Warten auf einen winzigen Effekt |

Ich bin zuversichtlich, dass Sie mit diesen Strategien die Qualität und Effizienz von erheblich verbessern können A/B-Tests auch bei begrenztem Datenverkehr, was zu genaueren und nützlicheren Ergebnissen für Ihren Online-Shop führt.

Fehler Nr. 8 – Konzentration ausschließlich auf quantitative Daten

In der Praxis stoße ich oft auf die Situation, dass die Ergebnisse von A/B-Tests ausschließlich auf quantitativen Daten basieren. Bei meiner Arbeit wurde mir klar, dass dies ein großer Fehler sein könnte. Hier sind einige der Hauptgründe, warum dies passiert, und wie Sie es vermeiden können.

Gründe, warum eine Schaltfläche möglicherweise nicht wirksam ist

🔑 Unauffälliger Button

Ich habe festgestellt, dass ein Button, der nicht in einer Kontrastfarbe hervorgehoben ist, einfach auf der Seite verloren geht . Um die Konvertierung zu verbessern, habe ich die Schaltflächenfarbe in eine hellere und kontrastreichere Farbe geändert – und es hat funktioniert! Jetzt lege ich immer Wert darauf, dass sich die Schaltfläche vom Rest des Inhalts abhebt.

📍 Schlechte Platzierung

Die Platzierung einer Schaltfläche an einer ungünstigen oder nicht offensichtlichen Stelle kann auch zu Ineffizienz führen. Einer meiner früheren Tests zeigte, dass das Verschieben der Schaltfläche weiter nach oben auf der Seite das Benutzererlebnis deutlich verbesserte. Ich empfehle Ihnen, sorgfältig zu analysieren, wo der Benutzer den Button erwartet, und ihn genau dort zu platzieren.

🤔 Unklarer Aufruf zum Handeln

Ein falsch formulierter Aufruf zum Handeln kann zu Unentschlossenheit führen Benutzer. In einem der Projekte habe ich das Standard-„Senden“ durch das spezifischere „Kostenlose Beratung erhalten“ ersetzt – und die Conversion gesteigert. Stellen Sie sicher, dass Ihr Anruf klar erklärt, was der Benutzer erhält.

Persönliche Erfahrungen und Beispiele

In einem meiner Tests haben mein Team und ich beschlossen, den Wortlaut des CTA zu ändern und seine Platzierung. Viele Nutzer ignorierten den Button zunächst einfach, da er sich am Ende der Seite befand und nicht sofort sichtbar war. Ich habe vorgeschlagen, die Schaltfläche höher zu verschieben und sie besser sichtbar zu machen. Für den Test haben wir drei weitere Optionen hinzugefügt: Eine wurde vergrößert, eine andere wurde heller gemacht und die dritte wurde im Originalzustand belassen.

Die Ergebnisse ließen nicht lange auf sich warten. Meine Hypothese wurde bestätigt: Schaltflächen, die besser sichtbar und höher platziert waren, erregten deutlich mehr Aufmerksamkeit des Benutzers. Dadurch verbesserte sich die Conversion um 15 %.

Daraus folgt, dass A/B-Tests nicht nur quantitative Daten, sondern auch qualitative Nutzerwahrnehmung berücksichtigen sollten.Beispiele für erfolgreiche und nicht erfolgreiche Tests

Erfolgreicher Test

- ✔️ Hypothese: Das Ändern der Farbe und Position der Schaltfläche erhöht die Conversions.

- ✔️ Ergebnis: Das Verschieben der Schaltfläche weiter oben auf der Seite und das Hervorheben mit einer Kontrastfarbe erhöhte die Anzahl der Klicks um 20 %.

Test fehlgeschlagen

- ❌ Hypothese: Das Hinzufügen einer Animation zu einer Schaltfläche wird mehr Aufmerksamkeit erregen.

- ❌ Ergebnis: Die Animation lenkte die Benutzer ab und sorgte für Irritationen, was zu einem Rückgang der Conversions um 5 % führte.

Empfehlungen

📝 Gründe für das Scheitern identifizieren {{|. 101|}}

Analysieren Sie immer, warum der Test ein bestimmtes Ergebnis zeigte. Ich empfehle dringend, nicht nur quantitative, sondern auch qualitative Analysemethoden wie Umfragen und Benutzerinterviews zu verwenden.

🔍 Testen Sie kleine Änderungen

Oft können subtile Änderungen große Auswirkungen auf das Ergebnis haben. Ich empfehle, kleine Änderungen schrittweise vorzunehmen und ihre Wirksamkeit zu analysieren.

📈 Daten im Kontext interpretieren

Ich achte immer auf die ganzheitliche Wahrnehmung der Seite, und zwar nicht nur auf die Conversion-Rate. Dadurch können Sie fundiertere Hypothesen für nachfolgende Tests aufstellen.

Übersichtstabelle

| Hilfreiche Schritte | Zu vermeidende Fehler | Hervorheben einer Schaltfläche mit einer Kontrastfarbe | Vernachlässigen der Schaltflächenplatzierung |

|---|---|

| Eine Schaltfläche an eine sichtbare Stelle verschieben | Animation ohne Testen verwenden | Ein klarer Aufruf zum Handeln | Eine Obsession mit quantitativen Daten | {{|. 111|}}

Ich bin überzeugt, dass es für erfolgreiches A/B-Testen wichtig ist, den gesamten Kontext der Benutzerinteraktion zu berücksichtigen und verlassen sich nicht nur auf quantitative Daten, sondern auch auf qualitative Wahrnehmung. Wenn Sie diese Richtlinien befolgen, können Sie häufige Fehler vermeiden und die Ergebnisse Ihres Online-Shops verbessern.

Fehler Nr. 9 – Testen unbedeutender Seiten

Erfahrung zeigt, dass einer der häufigsten Fehler beim A/B-Testen auf der Website eines Online-Shops darin besteht, unwichtige Seiten zu testen. Ich bin mir sicher, dass viele Online-Shop-Besitzer zunächst nicht erkennen, wie wichtig es ist, die richtigen Seiten zum Testen auszuwählen.

Fallstudie

Als ich anfing, A/B-Tests durchzuführen, habe ich den Fehler gemacht, mich auf Seiten zu konzentrieren, die aus ästhetischer Sicht verbesserungswürdig zu sein schienen, aber keinen sinnvollen Beitrag zu Conversions leisteten. Ich habe mich zum Beispiel entschieden, die Seite „Über uns“ zu testen, auf der wir die Geschichte unseres Unternehmens erzählt haben. Ich habe Wochen damit verbracht, verschiedene Versionen dieser Seite zu testen, in der Hoffnung, dass dadurch die Gesamtkonvertierung verbessert würde.

Leider zeigten die Ergebnisse, dass solche Seiten keinen spürbaren Einfluss auf den Umsatz haben. Dadurch habe ich viel Zeit und Mühe verloren, die ich auf wichtigere Elemente der Website hätte verwenden können.

Was tun?

Ich würde empfehlen, dass Sie sich auf das Testen von Seiten konzentrieren, die in direktem Zusammenhang mit dem Konvertierungsprozess stehen:

- 🎯 Produktkarte

- 🛒 Warenkorbseite

- 📋 Bestellformular {{|7|.}} 🏠 Startseite

Diese Seiten sind die wichtigsten Punkte, an denen der Benutzer eine Kaufentscheidung trifft. Die Optimierung einer Produktkarte kann beispielsweise das Testen verschiedener Optionen für Produktbeschreibungen, Bildqualität und -größe sowie die Platzierung der Schaltfläche „Kaufen“ umfassen.

Echtes Beispiel

In einem meiner Projekte habe ich mich auf die Optimierung der Warenkorbseite konzentriert. Wir haben A/B-Tests durchgeführt, um die Auswirkungen verschiedener Checkout-Button-Designs zu bewerten. Eine Option umfasste einen hellen, sichtbaren Button mit einem zusätzlichen Call-to-Action, die andere ein minimalistischeres Design.

Die Ergebnisse waren erstaunlich: Tests zeigten, dass die Version mit einer hellen Schaltfläche die Conversions um 10 % steigerte. Dies zeigte deutlich, wie wichtig es ist, die richtige Seite zum Testen auszuwählen.

Nützliche Tipps

Entdecken Sie-Analysen: 🕵️ Überlegen Sie, welche Seiten für Benutzer und Conversions am wichtigsten sind. Verwenden Sie Analysetools, um festzustellen, wo Benutzer die meiste Zeit verbringen und wo sie die Website am häufigsten verlassen.

Konzentrieren Sie sich auf die Konvertierung: 🎯 Testen Sie nur diese Seiten, die in direktem Zusammenhang mit dem Conversion-Pfad stehen. Dies wird dazu beitragen, Ihre gesamte Testeffizienz deutlich zu verbessern.

Bewerten Sie Prioritäten: 📊 Bestimmen Sie, welche Änderungen möglich sind den größten Nutzen bringen. Wenn eine Seite mit einer hohen Absprungrate wahrscheinlich optimiert werden muss, beginnen Sie dort.

Tabelle nützlicher und nutzloser Aktionen

| Nützliche Aktionen | Nutzlose Aktionen |

|---|---|

| 🎯 Produktkartentests | 📜 Seitentests „Über uns“ |

| 🛒 Optimierung der Warenkorbseite | 📊 Änderung der dekorativen Elemente auf der Kontaktseite |

| 📋 Verbesserung des Bestellformulars | {{|20|.}} 🖼️ Bildergalerie ohne Vertriebsanbindung testen|

| 🏠 Hauptseite ändern | 🎨 Änderung kleinerer Seiten, die sich nicht auf die Konvertierung auswirken |

Ich hoffe, dass diese Richtlinien Ihnen helfen, häufige Fehler zu vermeiden und Ihre Bemühungen auf die Elemente der Website zu konzentrieren, die sich wirklich auf den Handelsprozess auswirken. Ich bin zuversichtlich, dass Sie mit diesem Ansatz die A/B-Testergebnisse Ihres Online-Shops deutlich verbessern können.

Fehler Nr. 10 – Verschiedene Innovationen gleichzeitig testen

Aus persönlicher Erfahrung kann ich sagen, dass einer der häufigsten Fehler beim A/B-Testen auf der Website eines Online-Shops darin besteht, mehrere Innovationen gleichzeitig zu testen. Als ich zum ersten Mal darauf stieß, fiel es mir äußerst schwer zu bestimmen, welches Element die Konvertierung verbesserte. Infolgedessen waren die durchgeführten Tests nutzlos.

Um Zeit zu sparen, habe ich viele Änderungen vorgenommen: die Verkäufe aktualisiert Überschrift geändert, Preis geändert, Design-Layout neu gestaltet und Produktbilder geändert. Indem ich Split-Tests für alle diese Elemente gleichzeitig durchführte, konnte ich nicht herausfinden, welches tatsächlich erfolgreich war.

Dann wurde mir klar, dass der Ansatz geändert werden sollte. Ich empfehle jetzt , Tests für jedes einzelne Element einzeln durchzuführen.

Testbeispiele

Erfolgreicher Test: Seitentitel

🔍 Bearbeiten: Ich habe beschlossen, eine Verkaufsschlagzeile auf der Startseite zu testen. Der neue Titel war spezifischer und enthielt Schlüsselwörter, die die Zielgruppe ansprechen würden.

📈 Ergebnis: Conversion-Rate um 15 % erhöht. Ich kann mit Sicherheit sagen, dass es der neue Titel war, der das Ergebnis verbessert hat.

🔍 Änderung: Gleichzeitig wurden Titel, Preise und Produktbilder auf der Aktionsseite geändert.

📉 Ergebnis: Konvertierung blieb auf dem gleichen Niveau. Dies lieferte keine eindeutige Antwort auf die Wirksamkeit jeder Änderung, da es schwierig ist zu bestimmen, was funktioniert hat und was nicht.

In der Praxis habe ich gesehen, dass das gleichzeitige Testen vieler Änderungen zu falschen Ergebnissen führt. Es besteht eine hohe Wahrscheinlichkeit, dass sich erfolgreiche Anpassungen mit ineffektiven überschneiden und umgekehrt, was eine korrekte Bewertung erschwert.

Mein Rat

Ich empfehle dringend:

- ⏳ Testen Sie jedes Element einzeln. Testen Sie beispielsweise zuerst eine neue Überschrift und konzentrieren Sie sich nach Erhalt der Ergebnisse auf die Änderung der CTA-Schaltfläche.

- 📊 Führen Sie ein detailliertes Protokoll der durchgeführten Tests und erzielten Ergebnisse. Dies wird Ihnen helfen, die Wirksamkeit jeder Änderung zu verfolgen und Verwirrung zu vermeiden.

- 🔍 Nutzen Sie spezielle Tools für Analyse und Berichterstellung. Sie ermöglichen es Ihnen, die Wirkung jedes Elements genauer zu messen.

Beispiel Der richtige Ansatz

Als ich ein neues CTA-Button-Design getestet habe, habe ich es zunächst an einer begrenzten Gruppe von Benutzern getestet. Die Ergebnisse zeigten einen Anstieg der Klicks um 20 %. Nach einem erfolgreichen Test habe ich die Änderung auf der gesamten Website implementiert, was zu einer deutlichen Umsatzsteigerung führte.

Abschließende Überprüfung

Wichtige Punkte:

- 🚫 Testen Sie nicht mehrere Elemente gleichzeitig.

- ✅ Führen Sie für jedes Element separate Split-Tests durch.

- 📈 Verfolgen Sie die Ergebnisse jedes Tests separat.

- ✍️ Führen Sie ein Protokoll über Tests und Änderungen.

| Was zu tun ist | Was Sie vermeiden sollten {{|107|.}} |

|---|---|

| Einzelne Elemente testen | {{|. 20|}} Gleichzeitiges Testen mehrerer Elemente|

| Analysieren Sie die Ergebnisse jedes einzelnen Tests | Eine Seite vollständig ändern und alle Änderungen auf einmal verfolgen |

| Detaillierte Pflege Aufzeichnungen und Testberichte | Verlassen Sie sich auf die Intuition ohne Faktendaten |

Ich bin davon überzeugt, dass die Befolgung dieser Empfehlungen Ihnen dabei helfen wird, die Genauigkeit Ihrer A/B-Testergebnisse zu verbessern und die Konversionsrate Ihres Online-Shops zu verbessern.

Fehler Nr. 11 – Vernachlässigung der Wichtigkeit von Details auf der Verkaufsseite

{{|2|.}} Ich kann mit Sicherheit sagen, dass einer der Hauptfehler beim A/B-Testen auf einer Online-Shop-Website darin besteht, die Details auf der Verkaufsseite zu unterschätzen. Kein Wunder, dass fast jedes Detail eine entscheidende Rolle bei der Konvertierung spielen kann, sei es Hintergrundfarbe, Elementlayout, Menülayout, Text, Schriftart oder sogar Seitenlänge.

✏️ Beispiele

👎 Beispiel eines fehlgeschlagenen Tests: In einem der von mir betreuten Projekte änderte der Kunde nur die Hintergrundfarben der Hauptblöcke auf der Site, ohne verschiedene Optionen zu testen. Dies führte zu einem Rückgang der Gesamtkonvertierung um 15 %. Wir haben nicht berücksichtigt, dass diese Änderungen negative Auswirkungen auf die Wahrnehmung von Texten und Bildern haben könnten.

👍 Beispiel eines erfolgreichen Tests: In einer anderen Situation, nachdem komplexe A/B-Tests mit Änderung der durchgeführt wurden Farbschema und gleichzeitiger Verbesserung der Lesbarkeit der Schriftarten konnten wir die Konvertierung um 25 % steigern. Diese aufmerksame Liebe zum Detail hat unsere Erwartungen und Bemühungen gerechtfertigt.

Warum ist das wichtig?

Ich bin davon überzeugt, dass die Vernachlässigung der Details zu kolossalen Fehlern beim A/B-Testen führen kann. Hier sind ein paar Dinge, auf die Sie achten sollten:

- Hintergrund- und Elementfarbe: Es ist inakzeptabel, die Farbpalette zu ändern, ohne vorher deren Auswirkungen auf die Wahrnehmung des Standorts abzuschätzen.

- Elementlayout: Es ist wichtig zu beachten, dass eine falsche Platzierung von Schaltflächen oder wichtigen Informationen die Navigation für Benutzer erschweren kann .

- Menüansicht: Änderungen am Menü ohne Tests können die Benutzerfreundlichkeit der Website beeinträchtigen und potenzielle Kunden abschrecken.

- Texte und Schriftarten: Die Lesbarkeit von Texten und die richtige Auswahl der Schriftarten sind entscheidend für das Benutzererlebnis.

- Seitenlänge: Lange Seiten können Benutzer abschrecken, wenn die Informationen nicht richtig strukturiert sind.

Meine Empfehlungen

📊 Aufgrund meiner Erfahrung kann ich die folgenden bewährten Methoden empfehlen zur Fehlervermeidung:

- Sorgfältige Testplanung: Ich empfehle A/B-Tests dringend Achten Sie nicht nur auf die Hauptelemente der Seite, sondern achten Sie auch auf die kleinen Dinge, die die Conversion erheblich beeinflussen können.

- Integrierter Ansatz: Um verschiedene Aspekte der Verkaufsseite zu testen, ist es besser, einen integrierten Ansatz, das Testen, zu verwenden nicht ein Element nach dem anderen, sondern eine Kombination von Änderungen.

- Analyse der empfangenen Daten: Achten Sie sorgfältig auf die Analyse der Ergebnisse, um zu verstehen, was genau verursacht wurde die Änderung der Konvertierung.

Tabelle : Nützliche und nicht hilfreiche Aktionen

| Aktion | Nützlich | Nicht nützlich |

|---|---|---|

| Hintergrundfarbe ändern | ✅ Farbkombinationen testen | ❌ Farbe ändern ohne zu testen |

| Anordnung der Elemente | ✅ Bewerten Sie die Auswirkungen aus Bequemlichkeitsgründen | ❌ Ordnen Sie Elemente nach dem Zufallsprinzip neu an |

| Menü anzeigen | ✅ Ändern und testen | ❌ Unverändert lassen |

| Text und Schriftarten | ✅ Lesbarkeit verbessern | ❌ Wahrnehmungsauswirkungen ignorieren |

| Seitenlänge | ✅ Optimieren Inhalt | ❌ Seiten mit unnötigen Daten füllen |

Daher bin ich davon überzeugt, dass der richtige Ansatz beim A/B-Testing, der die Auswertung aller, auch kleinster Details der Verkaufsseite umfasst, dazu beitragen wird, häufige Fehler zu vermeiden und die Ergebnisse des Online-Shops deutlich zu verbessern .

Fehler Nr. 12 – Einstellungen während der Analyse ändern

Bei der Verwaltung eines Online-Shops bin ich immer wieder auf Situationen gestoßen, in denen sich die A/B-Testeinstellungen nach dem Start geändert haben, und ich kann mit Sicherheit sagen, dass dies eines der größten Hindernisse für die Erzielung zuverlässiger Ergebnisse ist. Um die Effizienz zu maximieren, änderte ich eines Tages die Testeinstellungen mitten im Zyklus. Es scheint, dass kleine Anpassungen die Leistung verbessern sollten, aber das Gegenteil geschah.

🤔 Um Fehler in Zukunft zu vermeiden, kann ich einige nützliche Strategien empfehlen:

📊 Vermeiden Sie es, den Test zu stören, wenn er bereits läuft.

🛠️ Nehmen Sie vorab alle notwendigen Einstellungen vor und prüfen Sie diese sorgfältig.

*🕰️ Warten Sie geduldig, bis der Test abgeschlossen ist, auch wenn die Ergebnisse nicht in die erwartete Richtung verlaufen.

Als ich die Testparameter änderte, führte dies zu schwerwiegenden Datenverzerrungen. Beispielsweise führte die Einführung neuer Elemente auf einer Seite zu einer Änderung des Nutzerverhaltens, was dazu führte, dass die Testergebnisse falsch wurden und nicht für objektive Schlussfolgerungen herangezogen werden konnten. Wenn ich bis zum Ende des Tests gewartet hätte, hätte ich mir ein klareres Bild machen können.

Wie kann man solche Fehler verhindern?

Entwicklung und Planung: Ich berate Sie gerne Führen Sie vor Beginn der Prüfung detaillierte Vorbereitungsarbeiten durch. Eines meiner erfolgreichen Projekte war die Erstellung eines Schritt-für-Schritt-Aktionsplans, der alles von Testzielen bis hin zu Erfolgskennzahlen umfasste.

Überprüfen Sie sorgfältig die Einstellungen: Alle Parameter müssen vor Beginn des Tests überprüft werden. Ich überprüfe immer abschließend alle Einstellungen für jede Variante, um sicherzustellen, dass sie korrekt sind.

Einstellungen korrigieren: Korrigieren Sie die Bedingungen, unter denen Der Test wird durchgeführt. Dazu gehören technische Elemente, Seiteninhalt und -design sowie zu messende Metriken.

.gif)

Die Hauptregel, die ich entwickelt habe: Keine Änderungen während des Tests. Dadurch können Sie Ihre Daten sauber halten und zuverlässige Ergebnisse erhalten.

📌 Überprüfungstabelle

| Nützliche Maßnahmen | Zu vermeidende Maßnahmen | |

|---|---|---|

| Gründliche Überprüfung der Einstellungen | Parameter nach dem Start ändern | |

| Genaue Planung | Einen Test in der Mitte stören | |

| Testbedingungen korrigieren | Verbesserungen ohne Analyse abgeschlossener Tests |

Aufgrund meiner Erfahrung empfehle ich, Tests immer als wissenschaftliche Experimente zu betrachten. Befolgen Sie diese Richtlinien und Ihre A/B-Tests werden zuverlässiger und effektiver.

Fehler Nr. 13 – Fehlende Datenbank mit Testergebnissen

Die Organisation von A/B-Testergebnissen ist ein grundlegender Faktor für eine erfolgreiche Analyse und anschließende datenbasierte Maßnahmen. Nur durch die systematische Dokumentation der Durchführung jedes A/B-Tests können Sie Wiederholungsfehler vermeiden und den Prozess optimieren. Ich habe aus eigener Erfahrung gelernt, dass das Fehlen einer detaillierten Datenbank zu Verwirrung und falschen Schlussfolgerungen führt.

Fallstudie

Bei einem meiner Projekte habe ich die Bedeutung der systematischen Pflege einer Datenbank mit Testergebnissen übersehen. Viele der von mir getesteten Hypothesen und Lösungen wurden nicht ordnungsgemäß dokumentiert, was zu doppelten Tests und Zeitverschwendung führte. Ich habe einmal einen Test auf einer Produktdetailseite durchgeführt, in der Hoffnung, die Conversions zu steigern, aber die Ergebnisse waren nicht schlüssig. Erst nach dem dritten Wiederholungstest, als ich endlich über eine detaillierte Datenbasis verfügte, wurde mir klar, welche Hypothesen wirksam waren und welche nicht.

So vermeiden Sie diesen Fehler

Zunächst würde ich Ihnen empfehlen, eine strukturierte Datenbank zu pflegen, die Folgendes enthält:

- 📝 Detaillierte Informationen zu Hypothesen

- 📊 Leistungsindikatoren getesteter Seiten

- 💡 Entscheidungen, die das erwartete Ergebnis brachten oder nicht brachten

- 📈 Wachstumsvolumina verschiedener signifikanter Indikatoren

Dieser Ansatz ermöglicht es Ihnen, wiederholte Fehler zu vermeiden und hilft Ihnen, Testergebnisse objektiver zu bewerten.

Wichtige Aspekte der Pflege einer Datenbank

*Details. Notieren Sie so viele Informationen wie möglich: Datum, Uhrzeit des Tests, verwendete Instrumente, Zweck des Tests und erzielte Ergebnisse.

👩💻 Automatisierung. Nutzen Sie spezielle Tools oder Plattformen, um die Pflege einer Datenbank zu vereinfachen. Dies können Google Sheets oder spezielle Analyselösungen sein.

⏳ Regelmäßige Updates. Die Relevanz der Informationen ist entscheidend. Aktualisieren Sie Ihre Datenbank regelmäßig, wenn neue Tests durchgeführt werden.

🧩 Struktur. Stellen Sie sicher, dass Ihre Datenbank logisch strukturiert und leicht lesbar ist. So können Sie schnell die benötigten Informationen abrufen und fundierte Entscheidungen treffen.

Ich empfehle Ihnen, über die Implementierung eines Testergebnis-Managementsystems nachzudenken, um die gesammelten Daten effektiver zum Nutzen Ihres Online-Shops zu nutzen.

Probleme aufgrund fehlender Datenbank

📉 Wiederholte Fehler. Ohne eine Datenbank ist es leicht, fehlgeschlagene Tests zu wiederholen, was nicht nur Zeit verschwendet, sondern sich auch negativ auf die Wahrnehmung der Marke durch die Kunden auswirkt.

🤷 In Fallen gefangen. In manchen Fällen kann das Fehlen einer Grundlinie zu falschen Schlussfolgerungen darüber führen, was für Ihr Publikum am besten funktioniert.

🔄 Mangelnder Fortschritt. Ohne eine klare Analyse der Ergebnisse ist es unmöglich, korrekte Hypothesen für weitere Verbesserungen aufzustellen, was die Entwicklung Ihres Unternehmens behindert.

Praktische Vorteile der Pflege einer Datenbank

- {{|. 7|}} 📈 Erhöhung der Genauigkeit von Analysen

- 📋 Optimierung von Ressourcen und Zeit

- 🎯 Verbesserung der Qualität von Hypothesen und weitere Tests

- 💰 Geld sparen und Rentabilität steigern

Übersichtstabelle

| Aktion | Hilfreich | Nicht nützlich |

|---|---|---|

| Pflege einer detaillierten Datenbank | ✅ | |

| Verwendung moderner Werkzeuge | ✅ | |

| Datenbankaktualisierung nach jedem Test | ✅ | |

| Vernachlässigung der Ergebnisanalyse | ❌ |

Ich bin davon überzeugt, dass die ordnungsgemäße Pflege einer Testdatenbank Ihrem Online-Shop große Vorteile bringen würde. Durch die Implementierung dieser Vorgehensweise können Sie Wiederholungsfehler vermeiden, Ihren Testprozess rationalisieren und letztendlich die finanzielle Leistung Ihres Unternehmens verbessern.

Fehler Nr. 12 – Fokus auf eine Seite: Warum vermeiden?

Mir ist aufgefallen, dass viele Online-Shop-Besitzer oft den gleichen Fehler machen: Sie bleiben beim Testen einer Seite hängen und versuchen, sie endlos zu verbessern. Dies mag logisch erscheinen, denn durch die Verbesserung der Schlüsselseite können Sie davon ausgehen, dass die Conversions steigen. Aber ich kann mit Sicherheit sagen, dass dies nicht immer der Fall ist.

Beispiel aus meiner Erfahrung

Als Beispiel habe ich mit einem Online-Elektronikgeschäft zusammengearbeitet, das alle seine Bemühungen auf die Homepage-Optimierung konzentrierte. Wir haben mehrere A/B-Testrunden durchgeführt, das Design verbessert, neue CTAs hinzugefügt und den Text geändert. Die Ergebnisse waren zunächst ermutigend, doch dann erlebten wir sinkende Erträge: Weitere Änderungen brachten nur minimale Steigerungen bei den Conversions.

🤔 Ich beschloss, die Strategie zu ändern und schlug dem Kunden vor, einen weiteren wichtigen Bereich zu testen – die Warenkorbseite. Und die Ergebnisse waren einfach erstaunlich. Die Optimierung der Warenkorbseite führte zu einem größeren Anstieg der Conversions als alle vorherigen Änderungen an der Startseite. Wir haben die Navigation verbessert, den Bestellvorgang vereinfacht, eine Schnell-Checkout-Option hinzugefügt – und die Conversions um 30 % gesteigert!

Warum passiert das?

📉 Die Fokussierung auf eine Seite führt zur sogenannten „Obergrenze“, ab deren Erreichen weitere Verbesserungen fast keine Ergebnisse mehr bringen. Ich empfehle dringend, auf andere Seiten Ihrer Website zu achten, die ebenfalls wichtig für die Conversion-Kette sind.

So vermeiden Sie diesen Fehler

🔍 Zunächst müssen Sie eine umfassende Analyse aller Phasen des durchführen Benutzerreise. Ermitteln Sie, auf welchen Seiten Ihre potenziellen Kunden den Kaufprozess am wahrscheinlichsten unterbrechen.

🛠️ Ich rate Ihnen, auf die folgenden Bereiche zu achten:

- ✨ Produktseite

- 💼 Produktkategorieseite

- 🛒 Warenkorbseite

- 🧾 Reihenfolge der Checkout-Seite

Optimierungstipp

Immer wenn ich über Verbesserungen in verschiedenen Bereichen einer Website nachdenke, folge ich einer bewährten Strategie:

- Datenanalyse: Ich beginne immer mit der Analyse von Benutzermetriken und Verhaltensdaten.

- Hypothesenbildung: Basierend auf der Analyse formuliere ich mehrere Hypothesen zum Testen.

- Durchführung von Experimenten: Durchführung von A/B-Tests, um festzustellen, welche Änderungen tatsächlich zu einer Steigerung der Conversions führen.

Wenn es irgendwann den Anschein hat, dass die Verbesserung einer Seite nicht die erwarteten Ergebnisse bringt, ist das ein sicheres Signal Dass es Zeit ist, zu einem anderen Bereich der Website zu wechseln.

Zusammenfassung

📊 In der Tabelle unten möchte ich zeigen, was sich lohnt und was lohnt sich bei A/B-Tests nicht:

| Was zu tun ist 🟢 | Was man nicht tun sollte 🔴 |

|---|---|

| Gesamte User Journey analysieren | Schleife auf einer Seite |

| Testen Sie verschiedene Bereiche der Website | Seiten mit geringer Conversion-Rate ignorieren |

| Verwenden Sie Daten, um Hypothesen zu formulieren | Nehmen Sie Änderungen ohne Analyse vor |

Daher empfehle ich Ihnen, sich die gesamte Käuferreise auf Ihrer Website anzusehen und nach Verbesserungsmöglichkeiten in jeder Phase zu suchen – das wird hilfreich sein Sie erzielen wesentlich aussagekräftigere Ergebnisse.

Fehler Nr. 15 – Wenden Sie erfolgreiche Ideen nicht ohne zusätzliche Tests auf andere Seiten an

Im Rahmen von A/B-Tests werden häufig sehr erfolgreiche Lösungen auf einer Online-Shop-Seite entdeckt. Ich erinnere mich an eine Zeit in einem meiner Projekte, in der wir Split-Tests durchgeführt haben, um den Seitentitel zu verbessern, was zu einer deutlichen Steigerung der Conversions führte. 🌟

Auf dieser Seite brachte die Änderung des Titels letztendlich +18 % an Gesamtumsatz Der Erfolg dieses Tests hat uns dazu inspiriert, die gleiche Idee auf andere Seiten der Website anzuwenden. Aber es ist wichtig, sich an ein entscheidendes Detail zu erinnern: Was auf einer Seite funktioniert, muss auf einer anderen nicht unbedingt so effektiv sein.

Am Beispiel unseres Teams: Nachdem wir denselben Header auf anderen Seiten der Website installiert hatten, stellten wir fest, dass die Conversions nicht nur nicht zunahmen, sondern auf einigen Seiten sogar leicht zurückgingen . Der Grund dafür könnten meiner Meinung nach die inhaltlichen und inhaltlichen Unterschiede auf diesen Seiten sein.

Hier sind einige Empfehlungen, die ich Ihnen aufgrund meiner Erfahrung geben möchte:

- 🚀 Es sind zusätzliche Tests erforderlich. Auch wenn eine Idee brillant erscheint und sich auf einer Seite bewährt hat, heißt das nicht, dass sie ohne Tests automatisch auf alle anderen Seiten übertragen werden kann.

- 🔔 Berücksichtigen Sie die Besonderheiten jeder-Seite. Als maßgeblicher Spezialist auf diesem Gebiet kann ich mit Sicherheit sagen: Jede Seite hat ihr eigenes Publikum und ihre eigene Besonderheit. Was für eine Zielgruppe funktioniert, muss nicht zwangsläufig auch für eine andere funktionieren.

- 💡 Erstellen Sie Hypothesen für jede-Seite. Anstatt eine erfolgreiche Lösung blind zu kopieren, schlage ich vor, für jede einzelne Seite Hypothesen zu entwickeln und diese vor Ort zu testen. So können Sie Situationen mit sinkenden Conversions vermeiden und optimale Lösungen für jede Seite finden.

Meiner Praxis nach zu urteilen, bin ich schon oft in diese Falle getappt – erfolgreiche Ideen ohne zusätzliche Tests zu übertragen, aber Mittlerweile mache ich das viel seltener.

Best Practices-Übersichtstabelle

| Üben | Nützlich | Nicht nützlich |

|---|---|---|

| Erfolgreiche Ideen auf anderen Seiten testen | ✅ Erhöht die Erfolgschancen | ❌ Risiko sinkender Conversions ohne Tests |

| Berücksichtigung der Besonderheiten der Seiten | ✅ Individueller Ansatz | ❌ Erstaunliche Erlebnisse ignorieren {{|110|.}} |

| Erstellen und Testen von Hypothesen | ✅ Erhöhung der Genauigkeit {{|110|.}} | ❌ Verlorene Zeit ohne Bestätigungen |

Durch die Anwendung meiner Tipps und Ansätze können Online-Shop-Inhaber und Vermarkter A/B-Tests effektiver nutzen und häufige Fehler bei ihrer Arbeit vermeiden. Ich empfehle dringend, auf die oben genannten Aspekte zu achten, um sicherzustellen, dass Ihre Bemühungen zu wirklich greifbaren Ergebnissen führen.

Fehler Nr. 16 – Ergebnisse nicht in Segmente aufteilen

Einer der Hauptfehler, der mir in meiner Praxis immer wieder aufgefallen ist, besteht darin, die Segmentierung der empfangenen Daten bei der Durchführung von A/B-Tests zu ignorieren. Wenn Testergebnisse zusammengefasst werden, ohne die Unterschiede zwischen den Segmenten zu berücksichtigen, können viele wichtige Nuancen verloren gehen, was letztendlich zu falschen Schlussfolgerungen und damit ineffektiven Entscheidungen führt.

Beispiel einer realen Situation

{{|2|.}} Lassen Sie mich eines meiner Beispiele vorstellen. In einem der Projekte für einen Online-Shop haben wir getestet, das Design der Produktseite zu ändern. Die Änderung war erfolgreich und führte zu einer Steigerung der Conversion-Raten für mobile Nutzer um 30 %. Wenn wir die Daten jedoch nicht segmentiert und einfach aggregiert mit Desktop-Benutzern analysiert hätten, wäre uns möglicherweise die Tatsache entgangen, dass die Änderung keine so großen Auswirkungen auf Desktop-Benutzer hatte.📝 Wichtige zu berücksichtigende Punkte:

- Verschiedene Benutzergeräte: Das Benutzererlebnis variiert stark je nach Gerät. 📱💻

- Akquisekanäle: Traffic-Kanäle, sei es organische Suche, soziale Netzwerke oder bezahlte Werbung, können ebenfalls Einfluss haben über die Testergebnisse. 🌐

- Geografische Segmente: Die Benutzergeografie kann ebenfalls eine wichtige Rolle spielen. 🌍

Warum ist Segmentierung wichtig?

Ich glaube, dass richtig segmentierte Daten ein genaueres Verständnis dafür liefern, wie verschiedene Benutzer auf Veränderungen reagieren. Dadurch können Sie Ansätze personalisieren und die Testeffizienz für jedes Segment verbessern.

Eine ordnungsgemäße Datensegmentierung hilft, falsche Schlussfolgerungen zu vermeiden und sorgt für ein genaues Verständnis der Realität.

Segmentierungsrichtlinien

🔍 Hier sind ein paar Dinge, die ich bei der Arbeit mit der Segmentierung beachten sollte:

- Geräte: Analysieren Sie Daten auf verschiedenen Geräten: Mobilgeräte, Desktops und Tablets.

- Verkehrsquellen: Segmentieren Sie Ihre Daten nach Verkehrsquellen – SEO, PPC, soziale Netzwerke und andere.

- Geographie: Sehen Sie sich Daten aus verschiedenen Ländern oder Regionen an.

- Tageszeit: Insbesondere wenn Ihr Online-Shop eine globale Reichweite hat, kann eine Aufteilung nach Zeitzone sinnvoll sein hilfreich.

🎯 Tipps zur Fehlervermeidung:

- Verwenden Sie Analysetools, die die Segmentierung Ihrer Daten erleichtern

- Überprüfen Sie die Segmente regelmäßig und passen Sie sie bei Bedarf an.

- Testen Sie Änderungen in großem Umfang und repräsentativ Proben für jede Gruppe

Überprüfung guter und schlechter Praktiken

| Nützliche Praktiken | Unerwünschte Praktiken | {{|108|.}}

|---|---|

| Daten nach Gerät segmentieren | Alle Daten in einer Gruppe zusammenführen |

| Ergebnisse nach Verkehrsquellen analysieren | Akquisitionskanäle ignorieren |

| Geografische Segmente berücksichtigen | Regionale Unterschiede vernachlässigen |

| Segmente nach Bedarf überarbeiten | Korrigieren Sie die Segmente ein für alle Mal. |

Das kann ich also getrost sagen Die Berücksichtigung von Segmentierungsdaten beim A/B-Testen eines Online-Shops ermöglicht es Ihnen, genauere und nützlichere Ergebnisse zu erhalten. Ich ermutige Sie, die Bedeutung dieser Vorgehensweise für den Erfolg Ihrer Marketingkampagnen zu bedenken.

Fehler Nr. 17 – Fehler beim Ablehnen einer Hypothese beheben, ohne zusätzliche Versionen zu prüfen

Ich möchte eine wichtige Lektion teilen, die ich bei der Durchführung von A/B-Tests für den von mir verwalteten Online-Shop gelernt habe. Es kommt häufig vor, dass die formulierte Hypothese aufgrund der Testergebnisse scheitert. Mir wurde jedoch klar, dass dies nicht immer bedeutet, dass die Hypothese falsch war. Das Problem lag oft in der Wahl der Implementierungsoption.

Beispiele für fehlgeschlagene und erfolgreiche Tests

{{|. 2|}} 🚀 Fehlgeschlagene Tests:Als ich das Ändern der Farbe der CTA-Schaltfläche testete, zeigte die ursprüngliche leuchtend rote Version eine schlechte Leistung. Ich hätte diese Hypothese sofort aufgeben können, aber stattdessen habe ich beschlossen, andere Farbtöne auszuprobieren.

Ein anderes Mal habe ich versucht, das Hauptbild durch ein emotionaleres zu ersetzen. Das erste Ergebnis war enttäuschend, aber anstatt die Idee komplett zu verwerfen, habe ich es mit einem anderen Bild und einem passenderen Text versucht. Dies führte zu einer deutlichen Verbesserung der Conversion-Raten.

🌟 Erfolgreiche Tests:

In einem der Tests habe ich beschlossen, die Anordnung der Elemente auf der Seite zu ändern. Das erste Layout brachte nicht die gewünschten Ergebnisse, aber durch die Änderung des Layouts fand ich eine effizientere Form, die die Verweildauer der Benutzer auf der Website erhöhte.

Beim Testen einer neuen CTA-Schaltflächenform sah die Originalversion schlecht aus, aber nach dem Ersetzen durch eine größere und Im Gegensatz dazu bemerkte ich einen deutlichen Anstieg der Klickraten.

Auswirkung von Fehlern auf Ergebnisse

Ich bin Stellen Sie sicher, dass das Aufgeben einer Hypothese ohne das Testen zusätzlicher Versionen dazu führen kann, dass Chancen verpasst werden. Mehrmals habe ich durch voreilige Schlussfolgerungen Potenzial für höhere Conversions und Benutzerzufriedenheit verloren. Wenn ich früher erkannt hätte, wie wichtig es ist, andere Optionen zu prüfen, hätte ich viele Fehler vermeiden können.

Techniken zur Fehlervermeidung

Ich empfehle Ihnen wärmstens:

📝 Probieren Sie verschiedene Formen aus:

- Verwenden Sie unterschiedliche Bilder und Texte.

- Seitenlayouts ändern.

- Experimentieren Sie mit dem Erscheinungsbild von CTA-Schaltflächen (Farbe, Größe, Text).

📊 Analysieren Sie die Ergebnisse jeder Option:

- Achten Sie genau auf die Kennzahlen.

- Vergleichen Sie die Ergebnisse jeder Änderung.

🔍 Betrachten Sie es genauer:

- Ich empfehle, den Kontext und die Umstände zu berücksichtigen.

- Es ist wichtig, Schlussfolgerungen auf der Grundlage mehrerer Tests zu ziehen.

Ich bin zuversichtlich, dass Sie durch die Anwendung dieser Methoden häufige Fehler vermeiden und bessere Ergebnisse beim A/B-Testen erzielen können.

Tabellen: nützliche und nicht hilfreiche Aktionen

| Nützliche Aktionen | Nicht hilfreiche Aktionen |

|---|---|

| Probieren Sie verschiedene Implementierungen aus | Verwerfen Sie die Hypothese nach dem ersten Test |

| Jede Version analysieren | A/B-Testergebnisse ignorieren |

| Kontext und Umstände berücksichtigen | Schlussfolgerungen basierend auf einem Test ziehen |

Best Practices:

- Gründliche Hypothesenvorbereitung: Ich versuche immer, aktuelle Probleme und Chancen gründlich zu analysieren.

- Testen verschiedener Versionen von: Es ist wichtig, mehrere Implementierungen zu testen.

- Teamarbeit: Die Einbeziehung von Kollegen in die Diskussion der Ergebnisse hilft, Subjektivität zu vermeiden.

Dieser Ansatz ermöglichte es mir, hohe Ergebnisse zu erzielen und ein Experte auf dem Gebiet des A/B-Testens für Online-Shops zu werden. Ich ermutige Sie, diese Tipps zu befolgen und selbstbewusst dem Erfolg entgegenzusteuern!

Fehler Nr. 18 – Suche nach großen Veränderungen

In In meiner Praxis habe ich einen häufigen Fehler erkannt, den viele, darunter auch ich, am Anfang meiner Karriere machen – den Wunsch, sofort große Veränderungen umzusetzen. Das erscheint auf den ersten Blick logisch: Je größer die Veränderungen, desto größer kann die Steigerung der Conversion und anderer KPIs ausfallen. Ich kam jedoch zu der Überzeugung, dass der Ansatz einer gründlichen Überarbeitung bedarf.

Meine Erfahrung: Wie die Implementierung großer Änderungen zum Scheitern führte

Als ich A/B-Tests zum ersten Mal auf einer meiner ersten Online-Plattformen einsetzte, war ich voller Begeisterung und nahm radikale Änderungen am Website-Design vor. Die Ergebnisse entsprachen jedoch überhaupt nicht meinen Erwartungen. Anstelle eines starken Anstiegs der Conversions bemerkte ich einen Rückgang der Schlüsselindikatoren und eine erhebliche Menge negativer Rückmeldungen von Benutzern. Dadurch wurde mir klar, wie wichtig schrittweise Veränderungen sind.

Warum umfangreiche Änderungen oft abstürzen

- 🛠️ Unvorhersehbarkeit der Leistung: Radikale Änderungen können zu riskant sein, da ihre Auswirkungen schwer vorherzusagen sind. Manchmal führen bereits kleine Änderungen im Design oder in der Funktionalität zu negativen Folgen.

- 💵 Erhöhte Kosten: Große Änderungen erfordern erhebliche finanzielle und zeitliche Ressourcen, was zu zusätzlichen Kosten führt und möglicherweise Verluste.

- 🤔 Probleme mit der Benutzerwahrnehmung: Benutzer sind an eine bestimmte Benutzeroberfläche und Funktionalität gewöhnt. Abrupte Veränderungen können zu Unzufriedenheit und Kundenabwanderung führen.

Beispiel für einen erfolgreichen Ansatz: inkrementelle Anpassungen

An einem der Projekte, an denen ich gearbeitet habe Am haben wir beschlossen, auf radikale Änderungen zu verzichten und uns auf inkrementelle kleine Verbesserungen zu konzentrieren. Die Implementierung schrittweiser Anpassungen, wie z. B. das Ändern der Schaltflächenfarben, die Verbesserung der Navigation und die Optimierung der Zielseiten, brachte wirklich deutlich positive Ergebnisse. Die Konvertierung begann allmählich zu wachsen und positive Nutzerbewertungen bestätigten die Richtigkeit der gewählten Strategie.

Empfehlungen zur Umsetzung kleiner Änderungen

🔍 Datenanalyse: Durch die regelmäßige Analyse statistischer Daten können Sie bestimmte Bereiche für kleine Verbesserungen identifizieren.

🖍 Inkrementelle Anpassungen: Ich empfehle dringend, klein anzufangen und jede Änderung einzeln zu testen. Dies wird dazu beitragen, Risiken zu minimieren und Kosten zu senken.

📊 Iterativer Ansatz: Durch die iterative Einführung von Änderungen können Sie deren Auswirkungen auf wichtige Kennzahlen besser verfolgen und Ihre Strategie anpassen entsprechend aus den erzielten Ergebnissen.

Meine Erfahrungen und Empfehlungen

Ich habe gesehen, dass durch eine rationale Verteilung von Änderungen spürbare Verbesserungen erzielt werden können, ohne Benutzer in eine Stresssituation zu bringen. Ich empfehle, dass Sie es vermeiden, auf große Veränderungen zu drängen, und sich auf schrittweise kleine Anpassungen konzentrieren. Ich bin zuversichtlich, dass dieser Ansatz zu stabileren und positiveren Ergebnissen führen wird.

Denken Sie daran: Kleine Änderungen können sich summieren und zu großen Verbesserungen im Großen führen Bild.

| Hilfreich | Nicht nützlich |

|---|---|

| Allmähliche Anpassungen | Radikale Veränderungen |

| Regelmäßige Datenanalyse | Gründliche Neugestaltung ohne Tests |

| Kleine Tests Änderungen | Flaches Testen großer Änderungen |

Ich bin zuversichtlich, dass die Umsetzung kleiner Änderungen zu erfolgreichen Ergebnissen und positivem Feedback der Benutzer führen wird.

Fazit: Hauptfehler beim A/B-Testen auf einer Online-Shop-Website

Fehler 1: Nicht ausreichend auf Tests vorbereitet

Einer der wichtigsten Aspekte erfolgreicher A/B-Tests ist eine gründliche Vorbereitung. Ich habe aus eigener Erfahrung gelernt, dass die Durchführung von Tests ohne angemessene Vorbereitung zu verzerrten Ergebnissen und Zeitverschwendung führen kann. In einem meiner Projekte waren beispielsweise keine klaren Testziele und Hypothesen definiert. Dies führte dazu, dass die Ergebnisse nicht aussagekräftig waren und keine eindeutigen Schlussfolgerungen zuließen.

So vermeiden Sie: {{|101 |.}}

- 📌 Ich empfehle Ihnen dringend, klare Ziele und Hypothesen zu definieren, bevor Sie mit dem Testen beginnen.

- 📌 Bewerten Sie die aktuelle Leistung und führen Sie vorläufige Datenanalysen durch, um Kontroll- und Testgruppen richtig festzulegen.

Fehler 2: Falsche Auswahl der Metriken

Eines meiner Projekte ist gescheitert, weil wir uns konzentriert haben auf Kennzahlen, die für das Endergebnis keine große Rolle spielten. Wir haben nur die CTR und die Verweildauer auf der Website gemessen, anstatt uns auf die Conversion und den durchschnittlichen Bestellwert zu konzentrieren.

So vermeiden Sie:

- {{|7 |.}} 👓 Ich empfehle, auf die wichtigsten Leistungsindikatoren (KPIs) zu achten, die für Ihr Unternehmen am wichtigsten sind.

- 👓 Entwickeln Sie ein Metriksystem, das Ihnen hilft, die tatsächlichen Auswirkungen von Änderungen zu verstehen.

Fehler 3: Unzureichende Stichprobengröße

Ich habe einmal einen Test durchgeführt, ohne sicherzustellen, dass dies der Fall ist Die Stichprobengröße war ausreichend. Dies führte zu Ergebnissen, die statistisch unzuverlässig waren und nicht für fundierte Entscheidungen herangezogen werden konnten.

So vermeiden Sie:

- {{|7 |.}} 📊 Ich würde empfehlen, vorläufige Stichprobengrößenberechnungen mit speziellen Rechnern durchzuführen.

- 📊 Warten Sie, bis der Test abgeschlossen ist, bis genügend Daten vorhanden sind, um statistisch signifikante Ergebnisse zu erzielen.

Fehler 4: Saisonalität und andere externe Faktoren ignorieren

In einem Fall haben wir A ausgeführt /B-Test am Vorabend eines wichtigen Feiertags, der die Ergebnisse aufgrund eines starken Anstiegs des Verkehrs stark verzerrte. Es war ein großer Fehler, saisonale Faktoren auf diese Weise zu ignorieren.

So vermeiden Sie: {{|101 |.}}

- 🎯 Ich rate Ihnen, bei der Planung von Tests alle saisonalen und externen Faktoren zu berücksichtigen.

- 🎯 Testen Sie während stabiler Phasen, um die Auswirkungen externer Ereignisse zu minimieren.

„Es ist besser, mehr Zeit mit der Vorbereitung und Planung zu verbringen, als Fehler zu korrigieren und ungenaue Daten zu erhalten“, Forbes-Artikel.

Praxisbeispiel und Empfehlungen

In einem meiner Projekte haben wir die Änderung des Farbschemas getestet eines Buttons „Kaufen“. In den frühen Testphasen stellten wir fest, dass sich die Conversion-Raten für die Gruppe mit der neuen Schaltfläche verbesserten. Als wir jedoch die Stichprobengröße erhöhten und saisonale Faktoren berücksichtigten, änderten sich die Ergebnisse in die entgegengesetzte Richtung. Dadurch konnten wir eine Fehlentscheidung vermeiden, die zu Verlusten geführt hätte.

Zusammenfassung:

🟢 Besser tun:

- Bereiten Sie sich sorgfältig auf den Test vor.

- Wählen Sie die richtigen Metriken.

- Sorgen Sie für eine ausreichende Stichprobengröße.

- Berücksichtigen Sie saisonale und externe Faktoren.

🔴 Nicht tun:

- Führen Sie einen Test durch ohne Vorbereitung.

- Konzentrieren Sie sich auf sekundäre Messwerte.

- Arbeiten Sie mit unzureichenden Daten.

- Ignorieren Sie den Einfluss externer Faktoren.

🛠️ Aufgrund dieser Erfahrung empfehle ich dringend, die oben genannten Methoden und Ansätze zu befolgen, um genaue und wertvolle Daten zu erhalten.

Erfahrung Unternehmen prom.ua

Unternehmen prom.ua ist einer der größten Online-Shops in der Ukraine und bietet ein breites Sortiment von Produkten verschiedener Anbieter. Das Hauptziel des Unternehmens besteht darin, den Benutzern einen bequemen und zuverlässigen Kaufprozess zu bieten und gleichzeitig hohe Konversionsraten für seine Verkäufer sicherzustellen.

Projektziele:

- Website-Conversion steigern

- Benutzererfahrung optimieren

- Anstieg der durchschnittlichen Überprüfung

- Rückgang der Absprungrate

Hauptproblem: Das Unternehmen war mit dem Problem niedriger Conversion- und hoher Absprungraten auf wichtigen Seiten der Website konfrontiert. Es wurde beschlossen, A/B-Tests durchzuführen, um die besten Lösungen zur Verbesserung dieser Indikatoren zu finden.

Zielgruppe: Primäre Zielgruppe prom.ua sind aktive Internetnutzer im Alter von 25 bis 45 Jahren, die lieber online einkaufen. Diese Nutzer legen Wert auf Komfort, Schnelligkeit und eine große Produktauswahl.

Hauptinteressen der Nutzer {{|101 |.}}:

- Bequeme Seitennavigation 🧭

- Schnelles Laden der Seite ⏱️

- Klare und detaillierte Produktbeschreibungen 📋

- Einfache Suche und Filterung von Produkten 🔍

- Zuverlässige Zahlungs- und Liefermethoden 💳

Beispiele erfolgreicher und nicht erfolgreicher Tests

{{|. 8|}} Erfolgreicher Test: Einer der erfolgreichsten Tests war ein Experiment mit der Änderung der Struktur von Lebensmittelkarten. s Hypothese war, dass eine Vergrößerung der Produktbilder und das Hinzufügen einer Schnellansicht-Schaltfläche das Benutzererlebnis verbessern und die Conversions steigern würden.

Ergebnisse:

- Steigerung der Conversion um 18 %

- Reduzierung der Absprungraten um 12 %

- Steigerung des durchschnittlichen Checks um 5 %

Testmerkmale:

- Kundensegment: Nutzer im Alter von 25–45 Jahren

- Testzeitraum: 4 Wochen

- Analysemethode: Statistische Signifikanz basierend auf Google Analytics-Daten

Test fehlgeschlagen: Einer der weniger erfolgreichen Tests war die Änderung des Farbschemas von die „Zum Warenkorb hinzufügen“-Schaltflächen. Hypothese: Das Ersetzen grüner Schaltflächen durch rote Schaltflächen wird mehr Aufmerksamkeit erregen und das Engagement erhöhen.

Ergebnisse:

- Rückgang der Conversion-Rate um 5 %

- Negative Nutzerbewertungen zum neuen Design

{{|. 8|}} Testmerkmale:

- Kundensegment: alle Website-Besucher

- Testzeitraum: 2 Wochen {{|7|.}} Analysemethode: Nutzerbefragungen und Google Analytics-Daten

Schlussfolgerungen und Empfehlungen

Fehler beim Testen wirken sich direkt auf die Ergebnisse aus und können zum gegenteiligen Effekt führen. Der kritischste Fehler, der bei prom.ua aufgetreten ist, war mit einem unzureichenden Testzeitraum verbunden.

Empfehlungen :

- Testen Sie regelmäßig 🗓️, um ständig an der Verbesserung der Website zu arbeiten.

- Verlängern Sie die Testzeiträume, um statistisch signifikante Daten zu erhalten.

- Erstellen Sie klare Hypothesen 📊, bevor Sie mit dem Test beginnen.

- Konzentrieren Sie sich auf Funktionalität 💻, nicht nur auf Design.

- Analysieren Sie Ihre Daten gründlicher 📉 damit Ihnen keine wichtigen Details entgehen.

Kundenangebot

„Die Durchführung regelmäßiger und sorgfältig geplanter A/B-Tests hat uns geholfen, wichtige Kennzahlen für Konversion und Kundenzufriedenheit deutlich zu verbessern.“ — Stanislav Loginov, Vertreter des Unternehmens prom.ua

Diese Schlussfolgerungen und Empfehlungen helfen Ihnen, häufige Fehler zu vermeiden und A/B-Tests zu einem effektiveren Werkzeug zur Verbesserung Ihres Online-Shops zu machen.

Häufig gestellte Fragen zum Thema: Die Hauptfehler beim A/B-Testen auf einer Online-Shop-Website und wie um sie zu vermeiden

1. Warum sollten Sie Split-Tests nicht ganz aufgeben oder unregelmäßig durchführen?

Split-Tests helfen Ihnen, die effektivsten Änderungen zu identifizieren, um die Conversions zu steigern und das Benutzererlebnis zu verbessern. Ohne sie werden Entscheidungen auf der Grundlage von Annahmen getroffen, was oft zu ineffektiven Ergebnissen führt.

2. Wie wichtig ist ein kurzer Testzeitraum?

Ein kurzer Testzeitraum kann zu falschen Ergebnissen führen, da nicht alle möglichen Variationen im Benutzerverhalten berücksichtigt werden. Dadurch steigt das Risiko, Fehlentscheidungen zu treffen.

3. Warum ist es wichtig, bei der Durchführung von Tests klare Hypothesen zu haben?

Klare Hypothesen helfen Ihnen, sich auf bestimmte Veränderungen und ihre möglichen Auswirkungen zu konzentrieren. Ohne sie werden Tests chaotisch und schwer zu interpretieren.

4. Welche Schäden können durch eine Überbetonung des Designs entstehen?

Wenn man sich nur auf das Design konzentriert, kann dies von funktionalen Aspekten und wichtigen Leistungsindikatoren ablenken, was zu einer Unterschätzung der Bedeutung von Inhalten und Benutzerfreundlichkeit führt.

5. Welche Risiken sind mit der Oberflächenmessung verbunden?

Die Messung nur oberflächlicher Messwerte wie Klicks oder Aufrufe liefert kein vollständiges Bild des Nutzerverhaltens und kann zu falschen Schlussfolgerungen über die Auswirkungen von Änderungen führen .

6. Welche Gefahren birgt die Auswahl irrelevanter Fokusgruppen?

Irrelevante Fokusgruppen führen zu verzerrten Ergebnissen, die nicht das tatsächliche Verhalten der Zielgruppe widerspiegeln, was zu unangemessenen Änderungen an der Website führen kann.

7. Warum ist das Testen bei geringem Verkehrsaufkommen wirkungslos?

Geringer Datenverkehr führt zu unzureichenden Daten, um zuverlässige Entscheidungen zu treffen, erhöht die Testzeit und erhöht die Wahrscheinlichkeit zufälliger Fehler.

8. Welche Auswirkungen hat es, wenn man sich ausschließlich auf quantitative Daten konzentriert?