Les principales erreurs des tests A/B sur un site de boutique en ligne et comment les éviter

-

Roman Revun

Copywriter Elbuz

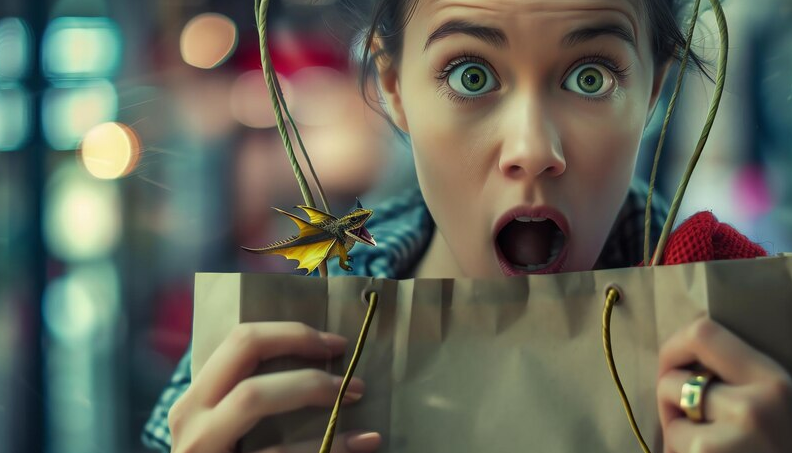

Lorsqu'il s'agit de tests A/B d'une boutique en ligne, il semblerait que tout soit simple : nous divisons les utilisateurs en deux groupes, montrons différentes versions de la page et comparons . Mais que se passe-t-il si une petite chose fait échouer tous vos efforts ? Imaginez que les créateurs d’une boutique en ligne à succès effectuent un tel test en modifiant un seul bouton. Oui, un seul, mais le résultat a été à l’opposé de ce qui était attendu. Quelles erreurs eux et des milliers d’autres entreprises n’ont-ils pas prises en compte ? Essayons de le comprendre ensemble.

Glossaire

🎯 Test A/B : Méthode d'évaluation modifications du site en créant deux versions de la page (A et B) et en mesurant leur efficacité pour les utilisateurs.

❌ Tests fractionnés : Variété A/ B les tests, qui consistent à diviser le trafic en segments égaux et à les envoyer vers différentes versions de la page pour évaluer les changements.

🕒 Période de test : Temps pendant lequel A Les tests /B sont effectués pour collecter suffisamment de données pour l'analyse.

🎯 Hypothèse : Une hypothèse à tester en cours de tests A/B, qui supposent que certains changements entraîneront des métriques améliorées.

🎨 Design : Composant visuel du site , y compris les polices, les couleurs, les images et les éléments de navigation.

📈 Métriques de surface : métriques de niveau supérieur , comme les clics et les pages vues, qui ne reflètent pas toujours le véritable comportement de l'utilisateur.

👥 Groupes de discussion : segments d'audience spécifiques sélectionnés participer à des tests afin d’obtenir des données pertinentes.

📉 Faible trafic : la situation dans laquelle le le site n'a pas suffisamment de visiteurs pour effectuer un test A/B statistiquement significatif.

📊 Données quantitatives : indicateurs numériques tels que l'engagement, les ventes et le temps passé sur place pour analyser les résultats des tests.

📄 Pages insignifiantes : pages du site qui le font ne joue pas un rôle clé dans le parcours utilisateur ou les objectifs commerciaux.

🔄 Tests simultanés : réalisation de plusieurs A/ B effectue des tests en même temps, ce qui peut conduire à des résultats mitigés et à des conclusions erronées.

🔍 Détails : éléments petits mais importants, tels que le libellé des boutons, le placement des éléments et les modifications visuelles mineures qui affectent l'expérience utilisateur.

⚙️ Paramètres d'analyse : configuration de l'outil de collecte et interprétation des données des tests.

📚 Base de données des résultats : collecte systématisée des données et les résultats des tests précédents ont été utilisés pour étayer les décisions futures.

🔄 Zone unique : Concentrez-vous sur une partie site ou un élément, en négligeant les autres opportunités d'amélioration.

🗺️ Segments : diviser les utilisateurs en groupes par certaines caractéristiques pour une analyse plus précise des résultats des tests.

🔄 Versions d'hypothèses : diverses approches et options changements qui sont testés pour confirmer ou infirmer une hypothèse.

🚀 Changements à grande échelle : changements importants au site liés à la conception, à la fonctionnalité ou à la structure qui comportent un risque élevé.

Erreur n°1 – Refuser de diviser les tests pas du tout ou les effectuer de manière irrégulière

Je peux affirmer avec certitude que l'une des erreurs les plus graves lors de la réalisation de tests A/B sur un site Web de boutique en ligne est le refus d'effectuer des tests fractionnés à la totalité ou leur mise en œuvre irrégulière. D'après mon expérience, j'ai constaté que de nombreux propriétaires de boutiques en ligne considèrent qu'effectuer des tests constants est une perte de temps et de ressources. Cependant, je peux vous assurer que des tests A/B réguliers sont la clé pour améliorer continuellement l'expérience utilisateur et augmenter les conversions.

Exemples de tests échoués issus de ma pratique

📉 L'un des clients a décidé d'effectuer des tests A/B une seule fois, estimant que cela suffirait pour obtenir les résultats souhaités. Malheureusement, sans analyse régulière et mise en œuvre de nouvelles idées, les résultats des tests n'ont pas eu d'effet à long terme et la conversion est rapidement revenue aux niveaux d'origine.

📉 Un autre exemple tiré de ma pratique est une entreprise qui a effectué des tests de manière irrégulière et sans plan clair. Les résultats de ces tests étaient chaotiques et ne conduisaient pas toujours à des améliorations.

Comment éviter les erreurs et améliorer les résultats

👨🔬 Je crois que la bonne Cette approche mettra en œuvre un plan systématique pour effectuer des tests A/B. Des tests réguliers vous permettent d'identifier rapidement les zones problématiques et de vous adapter aux évolutions du marché.

📊 Je vous encourage à vous pencher sur l'approche structurée des tests. Cela comprend :

- 📅 Planification – Créez un calendrier de tests régulier et respectez-le. .

- 🎯 Objectif axé – Définissez des objectifs spécifiques pour chaque test.

- 📝 Documentation - enregistrez tous les résultats afin de pouvoir les analyser au fil du temps.

- 📈 Analyse - analyse régulière des données obtenues et ajustement de la stratégie en fonction des résultats.

💡 Recommandations pour améliorer la fréquence des tests :

- 🤖 Automatisation des processus de tests à l'aide d'outils spécialisés.

- 📚 Former les employés pour créer une culture d'amélioration continue.

- 🛠 Utiliser des métriques et des KPI pour évaluer l'efficacité de chaque test.

Exemple personnel de test réussi

📈 Un de mes projets a montré des résultats impressionnants grâce aux tests A/B réguliers. Nous avons testé différentes variantes de titres, de descriptions de produits, de visuels et même de couleurs de boutons. Grâce à une approche systématique, nous avons pu augmenter le taux de conversion de 25 % en six mois. Cette expérience m'a convaincu que des tests réguliers sont la clé du succès.

Total

Je vous recommande donc fortement de ne pas commettre l'erreur de ne pas effectuer de tests A/B régulièrement ou de le faire de manière irrégulière. Ce processus nécessite de la discipline, mais les résultats en valent la peine.

| Pratiques utiles | Erreurs évitables |

|---|---|

| 📅 Tests réguliers | ❌ Tests irréguliers |

| 📊 Approche structurée de l'analyse | ❌ Chaotique et manque de plan |

| 📝 Documenter et analyser les résultats | ❌ Ignorer les capacités d'analyse |

| 🎯 Définir des objectifs spécifiques | ❌ Tester sans objectif ni structure |

Je suis convaincu que le respect de ces directives vous apportera des améliorations cohérentes et significatives à votre site de boutique en ligne.

Erreur n°2 – Période de test courte

I Je peux affirmer avec certitude que l'une des principales erreurs à éviter lors de la réalisation de tests A/B sur un site Web de boutique en ligne est la durée insuffisante du test. Dans ma pratique, j'ai rencontré des situations où des entrepreneurs étaient pressés d'arrêter les tests et, par conséquent, les tendances identifiées se sont révélées incorrectes.

Lorsque j'ai fait l'un des premiers tests, j'ai décidé que deux semaines suffisaient. suffisamment pour collecter des données sera suffisant. Les résultats semblaient encourageants et je me suis empressé de prendre une décision. Cependant, après quelques semaines, j’ai remarqué que les chiffres avaient changé dans la direction opposée et que les conclusions précédentes se sont révélées invalides. Depuis, je suis convaincu que plus les tests se prolongent, plus les résultats seront précis et fiables. Cela permet de prendre en compte les fluctuations saisonnières, les week-ends et jours fériés, ainsi que les évolutions numériques de l'audience.

Quelle période dois-je choisir pour les tests ?

🔵 Idéalement, la durée minimale du test devrait être de 2 à 3 semaines. Cela permet de couvrir l’ensemble du cycle des processus métier importants.

🔵 Il est conseillé d'éviter les grandes vacances et les hautes saisons. Pendant ces périodes, les données peuvent ne pas être représentatives et les conclusions peuvent être peu plausibles.

🔵 Tenez compte des facteurs externes : taux de change, changements dans les conditions du marché et autres circonstances pouvant affecter le comportement des utilisateurs.

Un exemple tiré de mon expérience : nous avons déjà effectué des tests sur le site avant le nouvel an. Nous voulions savoir quelle version de la page de destination générerait plus de ventes. Cependant, nous n'avons pas tenu compte du fait que la période des vacances entraîne une activité d'achat élevée, ce qui n'est pas typique du reste de l'année. Par la suite, après les vacances, nous avons constaté que les indicateurs baissaient fortement et que les conclusions tirées précédemment étaient inutiles. Depuis, j’ai toujours considéré la saisonnalité et évité les périodes de vacances importantes.

Quand pouvez-vous tirer des conclusions ?

Il est conseillé de tirer des conclusions après avoir atteint une signification statistique de 95 %. Cela vous permet d'obtenir une précision et une confiance maximales dans les résultats :

🟢 Définissez une période de test minimale.

🟢 Évaluez les résultats après avoir entièrement couvert tous les cycles de vente.

🟢 Testez en parallèle, en tenant compte des fluctuations saisonnières et hebdomadaires.

🟢 Faites attention à la signification statistique et aux cycles des processus métier.

Enfin, je tiens à souligner l'importance d'une planification minutieuse et d'une analyse minutieuse des données. C'est le seul moyen d'éviter les erreurs et d'obtenir des résultats précis qui contribueront à améliorer votre boutique en ligne.

Que faire et que ne pas faire

| Pratiques utiles | Ce qu'il faut éviter |

|---|---|

| 🟢 Tests à long terme (2-3 semaines) | 🔴 Courte période de test (moins d'une semaine) |

| 🟢 Prise en compte des facteurs externes (saisonnalité, vacances) | 🔴 Ignorer l'influence des vacances et des hautes saisons |

| 🟢 Atteindre une signification statistique de 95 % | 🔴 Prendre des décisions jusqu'à atteindre une signification statistique |

| 🟢 Tests parallèles | 🔴 Tests séparés sur différentes périodes |

Je vous recommande fortement de prendre en compte ces conseils et de planifier soigneusement vos tests. Des tests A/B réussis nécessitent de la patience et du soin, mais les résultats seront plusieurs fois payants.

Erreur n°3 – Réaliser un test sans hypothèses claires

Par le passé, j'ai été confronté à plusieurs reprises à des situations où des tests A/B sur un site de boutique en ligne étaient réalisés sans hypothèses explicites et fondées. Cette approche peut conduire à une inefficacité et à un gaspillage de ressources. Je peux affirmer avec certitude que les tests aléatoires produisent rarement des résultats commerciaux significatifs. Permettez-moi de partager mes réflexions et mon expérience.

Pourquoi les hypothèses sont-elles importantes ?

Je recommande fortement de formuler des hypothèses spécifiques avant de commencer tout test A/B. Une hypothèse est un point de départ qui définit ce que vous allez améliorer et pourquoi. Par exemple, j'ai déjà participé à un projet où la visibilité du bouton « Acheter » sur la page principale d'une boutique en ligne était faible, ce qui réduisait la conversion. J'ai suggéré qu'en changeant la couleur et la position du bouton, nous pourrions augmenter le nombre d'achats.

Comment construire des hypothèses ?

Pour construire une hypothèse, je suis toujours quelques étapes importantes :

🔍 Qu'est-ce que le problème? – Tout d'abord, je définis clairement le problème. Dans notre cas, il s'agissait d'une faible conversion.

🔍 Où est le problème ? – Ensuite, il est important de comprendre à quelle étape du processus le problème se manifeste. Dans cet exemple, il s'agissait de la page principale.

🔍 Cause du problème ? – Déterminer la cause du problème est essentiel. Nous nous sommes rendu compte que le bouton « Acheter » était difficile à voir.

🔍 Des solutions ? – Je propose des solutions possibles. Dans notre exemple, changer la couleur et l'emplacement du bouton.

🔍 Quels éléments dois-je modifier ? – Il est important de définir clairement quels éléments seront modifiés pour résoudre le problème.

Exemple tiré de ma pratique

À titre d'illustration, je vais donner un exemple spécifique. L'un de nos principaux clients m'a contacté pour me faire part d'un problème lié à un faible pourcentage d'abonnements à la newsletter. Nous avons supposé que le problème était un appel à l’action peu clair. Après avoir formulé un texte clair et plus clair pour le formulaire d'abonnement, nous avons commencé les tests. Au bout de trois semaines, le nombre d'abonnements a doublé.

Cette expérience réussie m'a montré à quel point il est important d'avoir des hypothèses claires. Tous les changements doivent être basés sur des faits et des observations, et non sur des conjectures.

« Pour réussir les tests A/B, formulez toujours des hypothèses claires et raisonnables. » – Ma règle principale.

Résumé et recommandations

Je suis sûr que le manque d'hypothèses spécifiques est l'une des les erreurs les plus courantes dans les tests A/B. Avant de commencer tout test, je recommande fortement :

📝 Formuler des hypothèses claires.

📊 Basez-les sur des faits et des données.

🔄 Identifiez clairement les éléments qui seront modifiés.

Effectuer des tests sur une période suffisamment longue pour obtenir des résultats fiables.

| Pratiques utiles | Erreurs évitables |

|---|---|

| Formuler des hypothèses claires | Test sans hypothèses |

| Baser les méthodes sur des faits | Agir de manière aléatoire |

| Définir clairement éléments | Étendre les changements sur l'ensemble du processus |

| Porter effectuer des tests longs | Effectuer des tests à court terme |

Je conseille fortement à tous les spécialistes du marketing numérique de prêter attention à la formulation correcte des hypothèses pour des tests A/B efficaces et efficients.

Erreur n°4 – Trop d'importance accordée au design

De D'après mon expérience, je peux affirmer avec certitude que l'une des erreurs courantes lors de la réalisation de tests A/B sur un site Web de boutique en ligne est l'accent excessif mis sur le design. Les entrepreneurs concentrent souvent tous leurs efforts sur la modification du design visuel de la page, oubliant que l’aspect clé est d’augmenter la conversion.

Lorsque j'ai effectué des tests A/B sur l'un des projets, nous avons d'abord attention portée au changement de l'apparence du site : couleurs, polices, icônes. Nous nous attendions à ce que cela conduise à une croissance impressionnante des ventes. Cependant, les résultats ont été loin de nos attentes : le taux de conversion n'a augmenté que de 2 %. Cela m’a fait penser que le design n’est pas toujours le principal facteur décisif.

Après avoir analysé les données, nous avons décidé de changer notre approche et de prêter attention à des détails plus petits mais importants :

✍️ Vendre headlines

Je pense que changer de titre est un élément important d'optimisation. Les titres doivent être clairs, intéressants et adaptés aux besoins de l'utilisateur. Par exemple, au lieu de « Nos meilleures offres », nous avons modifié le titre en « Remises exclusives seulement aujourd'hui - ne manquez pas cette occasion ! » Cela a attiré l’attention des utilisateurs et a considérablement accru leur intérêt pour l’offre.

📄 Corps du texte

Le corps du texte doit non seulement être unique, mais également spécifique. Au lieu de déclarations générales sur les produits, je recommande d'utiliser des descriptions qui répondent spécifiquement aux besoins des clients. Par exemple : « Nos baskets sont idéales pour les longues promenades et le sport, grâce à leur semelle légère et confortable. »

💡 Boutons CTA

Des appels à l'action clairs et compréhensibles sont essentiels. Je suis convaincu que les boutons avec du texte comme « Acheter maintenant » ou « Obtenir une remise » fonctionnent mieux que simplement « Suivant » ou « Plus de détails ». Dans mon cas, modifier le texte des boutons a augmenté la conversion de 15 %.

.gif)

🗺️ Localisation des éléments

La disposition des éléments sur la page joue également un rôle important. J'ai constaté que déplacer les boutons CTA plus haut sur la page améliore l'expérience utilisateur et donc les taux de conversion. Par exemple, nous avons placé des boutons « Acheter maintenant » à côté des images de produits et de leurs brèves descriptions.

🔍 Exemples de tests réussis

Sur l'un des projets, nous avons d'abord modifié uniquement la conception et n'avons pas obtenu de effet significatif. Plus tard, en appliquant les méthodes décrites ci-dessus, nous avons constaté une augmentation de 20 % des conversions. Cela a montré que mettre l’accent sur les éléments importants d’une page apporte des résultats tangibles.

"L'optimisation sur la page n'est pas seulement une question de conception. Il s'agit également de répondre aux besoins de l'utilisateur et d'améliorer son expérience." - Richard Newton, auteur de cinq livres d'affaires à succès, dont Project Management de A à Z.

Tableau de recommandations

| Que faire | Ce qu'il ne faut pas faire |

|---|---|

| 📑 Utiliser des titres de vente | ❌ Comptez uniquement sur les modifications de conception de page |

| ✍️ Écrivez de manière intéressante et unique corps du texte | ❌ Ignorer le texte correspondant aux demandes des utilisateurs |

| 📢 Installer des boutons CTA clairs et compréhensibles | ❌ Masquer les boutons en bas de page |

| 🏷️ Optimiser le placement des éléments | ❌ Essayez de modifier uniquement les composants visuels |

Ainsi, je vous conseille fortement de vous concentrer sur ces aspects lors de la réalisation de tests A/B. Considérez les détails petits mais importants qui peuvent améliorer considérablement vos taux de conversion.

Erreur n°5 – Rechercher des indicateurs superficiels

Mesurer l'efficacité d'une mise à jour de test nécessite une approche prudente et réfléchie. Je souhaite partager mon expérience personnelle, qui montre à quel point des indicateurs défectueux peuvent conduire à des conclusions erronées. Laissez-moi vous donner quelques cas de ma pratique.

Il y a eu des moments où mon équipe et moi avons remarqué une augmentation notable des likes et repost sur les réseaux sociaux après avoir lancé un nouveau design de page produit. Cela semble être un succès, mais lorsque nous avons commencé à analyser la conversion réelle, il est devenu évident que le nombre de ventes restait au même niveau. Ensuite, j'ai réalisé que des indicateurs tels que les likes et les republications ne sont pas toujours en corrélation avec la croissance des ventes.

Exemples et preuves de mes déclarations

🟢 Exemple 1 : Augmentation du nombre de visites sur le site.

Un jour, nos tests ont conduit à une augmentation du trafic sur le site. À première vue, cela semble être un excellent résultat, mais si l’on y regarde de plus près, l’augmentation des commandes reste négligeable. Cela m’a fait réaliser qu’une augmentation du trafic sur un site Web ne garantit pas une augmentation des ventes.

🟢 Exemple 2 : Augmentation du nombre d'abonnés à la newsletter.

Un autre cas de ma pratique est une newsletter, après laquelle les statistiques d'abonnement ont considérablement augmenté. Cependant, l’analyse a montré que la conversion réelle des nouveaux abonnés en clients réels était minime. Cela m'a encore une fois prouvé qu'il ne fallait pas attacher trop d'importance à cet indicateur.

En commettant ces erreurs, vous pouvez perdre du temps et des ressources à optimiser des paramètres qui ne profitent pas vraiment à votre entreprise. Il est important de se concentrer sur les indicateurs qui affectent directement la conversion et les bénéfices de l’entreprise. Je recommande toujours de prendre en compte non seulement des mesures superficielles, mais également d'examiner les résultats financiers réels.

Comment éviter les erreurs de mesure des indicateurs de surface ?

🔍 Astuce 1 : Identifiez les indicateurs de performance clés (KPI) avant de tester.

Je vous encourage à commencer par définir clairement quelles mesures sont fondamentales pour votre entreprise. Pour une boutique en ligne, cela peut être une conversion et un revenu. D’autres indicateurs, bien qu’utiles, doivent rester en arrière-plan.

🔍 Astuce 2 : Analysez les données de manière globale.

Ne vous précipitez pas pour tirer des conclusions si vous constatez une augmentation de l'un des indicateurs. Comparez-le avec d'autres métriques et suivez la logique générale des changements. Par exemple, une augmentation du nombre de likes sur les réseaux sociaux, c’est bien, mais il est plus important de comprendre si cela a entraîné une augmentation du nombre de commandes.

🔍 Astuce 3 : Tenez compte de l'influence de la saisonnalité et des facteurs externes.

J'ai souvent vu des statistiques influencées par des facteurs tels que des vacances ou une promotion. Tenez toujours compte du contexte des changements pour éviter de tirer de mauvaises conclusions.

Bloquer -diagramme pour améliorer l'approche de mesure :

- 💡 Clarifier les objectifs et les KPI.

- 💡 Analysez les métriques ensemble.

- 💡 Considérez le contexte externe.

Je suis convaincu que la bonne approche d'analyse des indicateurs permet d'obtenir les résultats les plus fiables et de prêter attention à ces aspects qui sont vraiment importants pour les entreprises. La mise en pratique de ce principe a grandement amélioré nos résultats de tests A/B, et je suis convaincu que suivre ces conseils vous aidera à éviter les erreurs courantes.

Erreur n°6 – Sélectionner des groupes de discussion non pertinents

Une erreur courante lors de la réalisation de tests A/B dans les boutiques en ligne est de choisir des groupes de discussion non pertinents pour tester les changements. Pour illustrer la gravité du problème, je vais raconter mon histoire.

J'ai récemment travaillé avec une boutique en ligne qui souhaitait tester une interface de panier mise à jour. Les dirigeants de l'entreprise ont décidé de ne pas perdre de temps ni d'argent pour attirer un nouveau public et de n'utiliser que leurs employés et leurs connaissances pour les tests. Cela semblerait logique : ils achètent tous souvent des produits dans ce magasin et en connaissent toutes les nuances. Mais le résultat s’est avéré loin de la réalité.

Problèmes lors des tests sur des amis :

- 🛑 Biais d'opinion : Les personnes travaillant pour ou à proximité d'une entreprise ont tendance à connaître les processus internes et peuvent inconsciemment embellir les résultats. .

- 🛑 Pas assez de diversité : Le bassin de connaissances ne reflète souvent pas la diversité du public cible.

- 🛑 Score incomplet : Comprendre les processus internes peut rendre difficile l'évaluation objective des mises à jour.

Après avoir analysé les résultats des tests, j'ai remarqué qu'il y avait un écart significatif entre les résultats des tests et les réactions des vrais clients. Cela est devenu évident après la mise en œuvre des changements, lorsque les taux de conversion ont diminué et que le nombre de plaintes a augmenté.

Comment éviter cette erreur

Je recommande d'envisager les étapes suivantes pour un groupe de discussion réussi sélection :

- Créer un portrait précis du public cible : Avant Dans l'ensemble, je dresse toujours un portrait détaillé d'un acheteur potentiel, en tenant compte des caractéristiques démographiques et psychographiques.

- Utiliser des plateformes tierces pour recruter des utilisateurs : je recrute souvent des participants via des plateformes spécialisées telles que UserTesting ou UsabilityHub. Cela m'aide à obtenir l'avis de personnes qui ne connaissent pas les processus internes de l'entreprise.

- Collecte et analyse de données : Mener des recherches sur un large échantillon et analyser les résultats pour obtenir des données objectives.

Exemple de test réussi :

Sur la base de mes erreurs, j'ai retesté en utilisant les méthodes décrites ci-dessus. À l’aide d’une plateforme tierce, j’ai constitué un groupe de discussion de 1 000 nouveaux utilisateurs correspondant au public cible. Les résultats étaient plus précis et plus utiles : les modifications de panier ont entraîné une augmentation de 15 % des conversions, et cela était clairement visible dès les premières semaines après la mise en œuvre.

« Les tests avec des utilisateurs aléatoires nous ont fourni des données plus fiables. Cela nous a aidé à éviter les préjugés et à améliorer la qualité du produit. » – Igor Volyunets, responsable marketing de la société ALLO.

Conseils utiles :

- ✔ Réaliser des tests sur différents segments du public cible

- ✔ Utiliser des plateformes professionnelles pour attirer des participants

- ✔ Analyser les résultats pour identifier les tendances communes et éliminer les anomalies

Avantages et risques :

| Action | Utile | Non recommandé |

|---|---|---|

| Sélection de vrais représentants du public cible | Augmente l'objectivité | - |

| Utilisation du cercle intérieur | - | Augmente le biais |

| Utilisation de plateformes tierces | Fournit des opinions diverses | Nécessite des frais supplémentaires |

Suivre ces directives et je suis sûr que vos tests A/B deviendront plus précis et utiles pour votre boutique en ligne.

Erreur n°7 – Tests dans des conditions de faible trafic

Sur la base de mon expérience en matière de tests A/B sur diverses boutiques en ligne, je peux affirmer avec certitude que les tests dans des conditions de faible trafic sont l'une des erreurs les plus courantes. Un exemple de cette situation est un projet sur lequel j'ai travaillé il y a quelques années, où une boutique en ligne a décidé de tester une nouvelle version d'une page produit tout en limitant considérablement le nombre de visites.

📉Pourquoi cette approche ne fonctionne pas :

- Données insuffisantes. Lorsque le trafic sur le site est faible, l’échantillon collecté est trop petit pour tester les hypothèses de manière statistiquement significative. Par conséquent, les données obtenues peuvent être anecdotiques et ne pas refléter l’impact réel des changements.

- Temps de test long. Lorsque le trafic est faible, les tests peuvent durer des mois, ralentissant le processus de prise de décision et la mise en œuvre d'améliorations utiles.

- Dépenses injustifiées. Tenter des tests dans de telles conditions entraîne souvent des coûts inutiles, car de l'argent et du temps sont perdus sur un test dont les résultats ne peuvent pas être utilisés en toute confiance.

"Faire un test A/B avec un faible trafic, c'est comme essayer d'entendre de la musique dans une avenue bruyante : il y a beaucoup de bruit et peu de clarté. — expert en analyse en ligne chez Prom, Ilya Vdovin.

🥇 Bonnes pratiques pour éviter cette erreur :

- Concentrez-vous sur les pages à fort trafic. Je recommande fortement de se concentrer sur les pages avec le plus de trafic, comme la page d'accueil ou les pages de catégories de produits. Cela fournit suffisamment de données pour exécuter un test A/B significatif.

- Utilisation de microconversions. Si le taux de conversion principal est trop faible, je suggère d'utiliser des micro-conversions, comme des clics sur certains boutons ou l'ajout d'articles au panier. Cela vous permettra de collecter rapidement les statistiques nécessaires.

- Consolidation du trafic de plusieurs sources. Dans l'un des projets que j'ai dirigés, nous avons combiné les données de plusieurs de nos sites de marques pour augmenter le trafic. Après cela, les tests sont devenus plus significatifs et interprétables.

Quelques conseils spécifiques :

- Je pense que la bonne solution est de mener des tests pilotes en se concentrant sur les pages les plus visitées.

- Je pense que les mesures doivent être étroitement surveillées et mesurées correctement pour obtenir une évaluation précise des résultats.

- Je trouve utile de revoir régulièrement les hypothèses et de les adapter aux conditions actuelles et à la dynamique du trafic.

Tableau : Que faire et qu'éviter lors de la réalisation de tests A/B dans des conditions de faible trafic

| Actions utiles | Actions à éviter |

|---|---|

| ✅ Concentrez-vous sur les pages à fort trafic | ❌ Testez les pages à faible trafic |

| ✅ Utiliser des micro-conversions | ❌ Ignorer les métriques intermédiaires |

| ✅ Agrégation du trafic pour augmenter l'échantillon | ❌ Tests longs avec des résultats incertains |

| ✅ Révision régulière des hypothèses | ❌ En attente d'un effet infime |

Grâce à ces stratégies, je suis convaincu que vous pouvez améliorer considérablement la qualité et l'efficacité de Des tests A/B même dans des conditions de trafic limité, ce qui conduira à des résultats plus précis et utiles pour votre boutique en ligne.

Erreur n°8 – Se concentrer uniquement sur les données quantitatives

Dans la pratique, je suis souvent confronté à une situation où les résultats des tests A/B reposent uniquement sur des données quantitatives. Dans mon travail, j'ai réalisé que cela pouvait être une grave erreur. Voici quelques-unes des principales raisons pour lesquelles cela se produit et comment vous pouvez l’éviter.

Raisons pour lesquelles un bouton peut ne pas être efficace

🔑 Bouton discret

J'ai découvert qu'un bouton qui n'est pas mis en évidence dans une couleur contrastée se perd tout simplement sur la page . Voulant améliorer la conversion, j'ai changé la couleur du bouton pour quelque chose de plus clair et de plus contrasté - et cela a fonctionné ! Maintenant, je me fais toujours un devoir de m'assurer que le bouton se démarque du reste du contenu.

📍 Un mauvais placement

Placer un bouton dans un endroit difficile ou non évident peut cela entraîne également son inefficacité. L'un de mes tests précédents a montré que déplacer le bouton plus haut dans la page améliorait considérablement l'expérience utilisateur. Je vous conseille d'analyser soigneusement l'endroit où l'utilisateur s'attend à voir le bouton et de le placer exactement là.

🤔 Appel à l'action peu clair

Un appel à l'action mal formulé peut provoquer une indécision dans utilisateurs . Dans l'un des projets, j'ai remplacé le standard « Envoyer » par le plus spécifique « Obtenir une consultation gratuite » - et la conversion a augmenté. Assurez-vous que votre appel explique clairement ce que l'utilisateur obtiendra.

Expérience personnelle et exemples

Lors d'un de mes tests, mon équipe et moi avons décidé de modifier le libellé du CTA. et son placement. Au départ, de nombreux utilisateurs ignoraient simplement le bouton, car il se trouvait en bas de la page et n'était pas immédiatement visible. J'ai suggéré de déplacer le bouton plus haut et de le rendre plus visible. Pour le test, nous avons ajouté trois options supplémentaires : l’une a été agrandie, une autre a été rendue plus lumineuse et la troisième a été laissée dans son état d’origine.

Les résultats ne se sont pas fait attendre. Mon hypothèse s’est confirmée : les boutons plus visibles et situés plus haut attiraient nettement plus l’attention des utilisateurs. En conséquence, la conversion s'est améliorée de 15 %.

Il s'ensuit que les tests A/B doivent prendre en compte non seulement les données quantitatives, mais également la perception qualitative des utilisateurs.Exemples de tests réussis et non réussis

Test réussi

- ✔️ Hypothèse : Changer la couleur et la position du bouton augmentera les conversions.

- ✔️ Résultat : Déplacer le bouton plus haut sur la page et le surligner avec une couleur contrastée a augmenté le nombre de clics de 20%.

Test échoué

- ❌ Hypothèse : L'ajout d'une animation à un bouton attirera davantage l'attention.

- ❌ Résultat : L'animation a distrait les utilisateurs et provoqué une irritation, ce qui a entraîné une diminution de 5 % des conversions.

Recommandations

📝 Identifier les raisons de l'échec

Analysez toujours pourquoi le test a montré un résultat particulier. Je recommande fortement d'utiliser des méthodes d'analyse non seulement quantitatives mais également qualitatives, telles que des enquêtes et des entretiens avec les utilisateurs.

🔍 Tester de petits changements

Des changements souvent subtils peuvent avoir un impact important sur le résultat. Je recommande d'apporter de petits changements progressivement et d'analyser leur efficacité.

📈 Interpréter les données dans leur contexte

Je fais toujours attention à la perception holistique du page, et pas seulement sur le taux de conversion. Cela vous permet de formuler des hypothèses plus éclairées pour les tests ultérieurs.

Tableau récapitulatif

| Étapes utiles | Erreurs à éviter |

|---|---|

| Mettre en surbrillance un bouton avec une couleur contrastée | Négliger le placement du bouton |

| Déplacer un bouton vers un endroit visible | Utiliser l'animation sans tester |

| Un appel clair à l'action | Une obsession pour les données quantitatives |

Je suis convaincu que pour réussir les tests A/B, il est important de prendre en compte l'ensemble du contexte de l'interaction utilisateur et s'appuient non seulement sur des données quantitatives, mais également sur une perception qualitative. En suivant ces directives, vous pouvez éviter les erreurs courantes et améliorer les résultats de votre boutique en ligne.

Erreur n°9 – Tester des pages insignifiantes

Expérience montre que l'une des erreurs les plus courantes lors des tests A/B sur un site Web de boutique en ligne consiste à tester des pages sans importance. Je suis sûr que de nombreux propriétaires de boutiques en ligne ne réalisent pas au début à quel point il est important de choisir les bonnes pages à tester.

Étude de cas

{{|2| } Lorsque j'ai commencé à faire des tests A/B, j'ai commis l'erreur de me concentrer sur des pages qui semblaient avoir besoin d'être améliorées d'un point de vue esthétique mais qui n'apportaient pas une contribution significative aux conversions. Par exemple, j'ai choisi de tester la page « À propos de nous », où nous racontions l'histoire de notre entreprise. J'ai passé des semaines à tester différentes versions de cette page, en espérant que cela améliorerait la conversion globale.Malheureusement, les résultats ont montré que ces pages n'ont pas d'impact tangible sur les ventes. En conséquence, j’ai perdu beaucoup de temps et d’efforts qui auraient pu être consacrés à des éléments plus importants du site.

Que faire ?

Je vous recommande de vous concentrer sur le test des pages directement liées au processus de conversion :

- 🎯 Fiche produit

- 🛒 Page du panier

- 📋 Formulaire de commande

- 🏠 Page d'accueil

Ces pages sont les points clés où l'utilisateur prend une décision d'achat. Par exemple, l'optimisation d'une fiche produit peut inclure le test de différentes options pour les descriptions de produits, la qualité et la taille de l'image, ainsi que l'emplacement du bouton Acheter.

Exemple réel

Dans l'un de mes projets, je me suis concentré sur l'optimisation de la page du panier. Nous avons effectué des tests A/B pour évaluer l'impact de différentes conceptions de boutons de paiement. Une option comprenait un bouton lumineux et visible avec un appel à l'action supplémentaire, l'autre un design plus minimaliste.

Les résultats ont été étonnants : les tests ont montré que la version avec un bouton lumineux augmentait les conversions de 10 %. Cela a clairement montré à quel point il est important de choisir la bonne page à tester.

Conseils utiles

Explorez les analyses : 🕵️ Réfléchissez aux pages qui comptent le plus pour les utilisateurs et les conversions. Utilisez des outils d'analyse pour déterminer où les utilisateurs passent le plus de temps et où ils quittent le site le plus souvent.

Focus sur la conversion : 🎯 Testez uniquement ceux pages directement liées au chemin de conversion. Cela contribuera à améliorer considérablement l’efficacité globale de vos tests.

Évaluer les priorités de : 📊 Déterminer les changements qui peuvent apporter le plus grand bénéfice. Si une page avec un taux de rebond élevé a probablement besoin d'être optimisée, commencez par là.

Tableau des actions utiles et inutiles

| Actions utiles | Actions inutiles |

|---|---|

| 🎯 Test des fiches produits | 📜 Test des pages " À propos de nous " |

| 🛒 Optimisation de la page panier | 📊 Changement des éléments de décoration sur la page contact |

| 📋 Amélioration du bon de commande | 🖼️ Test de la galerie d'images sans connexion commerciale |

| 🏠 Changer la page principale | 🎨 Modification des pages mineures n'affectant pas la conversion |

J'espère que ces directives vous aideront à éviter les erreurs courantes et à concentrer vos efforts sur les éléments du site qui ont réellement un impact sur le processus de trading. Je suis convaincu qu'en adoptant cette approche, vous pouvez améliorer considérablement les résultats des tests A/B de votre boutique en ligne.

Erreur n°10 – Tester différentes innovations en même temps

D'après mon expérience personnelle, je peux dire que l'une des erreurs courantes lors des tests A/B sur un site Web de boutique en ligne consiste à tester plusieurs innovations en même temps. Lorsque j’ai rencontré cela pour la première fois, j’ai trouvé extrêmement difficile de déterminer quel élément améliorait la conversion. De ce fait, les tests effectués se sont révélés inutiles.

Pour gagner du temps, j'ai apporté beaucoup de modifications : mise à jour des ventes titre, modifié le prix, repensé la mise en page et modifié les images du produit. En exécutant des tests fractionnés sur tous ces éléments en même temps, je n'ai pas pu déterminer lequel était réellement réussi.

Ensuite, j'ai réalisé que l'approche devait être modifiée. Je recommande maintenant d'exécuter des tests pour chaque élément individuel un par un.

Exemples de tests

Test réussi : Titre de la page

🔍 Modifier : J'ai décidé de tester un titre de vente sur la page d'accueil. Le nouveau titre était plus spécifique et contenait des mots-clés susceptibles de plaire au public cible.

📈 Résultat : Taux de conversion augmenté de 15 %. Je peux dire avec certitude que c'est le nouveau titre qui a amélioré le résultat.

🔍 Modification : En même temps, modification du titre, des prix et des images des produits sur la page des promotions.

📉 Résultat : La conversion est restée au même niveau. Cela n’a pas fourni de réponse claire quant à l’efficacité de chaque changement, car il est difficile de déterminer ce qui a fonctionné et ce qui n’a pas fonctionné.

En pratique, j'ai vu que tester plusieurs changements en même temps conduisait à de faux résultats. Il existe une forte probabilité que des ajustements réussis se superposent à des ajustements inefficaces et vice versa, ce qui rend difficile une évaluation correcte.

Mon conseil

Je recommande vivement :

- ⏳ Testez chaque élément séparément. Par exemple, testez d’abord un nouveau titre et après avoir obtenu les résultats, concentrez-vous sur la modification du bouton CTA.

- 📊 Tenir un journal détaillé des tests effectués et des résultats obtenus. Cela vous aidera à suivre l’efficacité de chaque changement et à éviter toute confusion.

- 🔍 Utilisez des outils spécialisés pour l'analyse et le reporting. Ils vous permettront de mesurer plus précisément l’impact de chaque élément.

Exemple la bonne approche

Lorsque je testais un nouveau design de bouton CTA, je l'ai d'abord testé sur un groupe limité d'utilisateurs. Les résultats ont montré une augmentation de 20 % des clics. Après un test réussi, j'ai mis en œuvre le changement sur l'ensemble du site, ce qui s'est traduit par une augmentation significative des ventes.

Révision finale

Points importants :

- 🚫 Ne testez pas plusieurs éléments en même temps.

- ✅ Exécutez des tests fractionnés distincts pour chaque élément.

- 📈 Suivez les résultats de chaque test séparément.

- ✍️ Tenir un journal des tests et des modifications.

| Que faire | Ce qu'il faut éviter |

|---|---|

| Tester des éléments individuels | Tests simultanés de plusieurs éléments |

| Analyser les résultats de chaque test individuel | Changer complètement une page et suivre toutes les modifications en même temps |

| Maintenir des informations détaillées enregistrements et rapports de tests | S'appuyer sur l'intuition sans données factuelles |

Je suis convaincu que suivre ces recommandations vous aidera à améliorer la précision de vos résultats de tests A/B et à améliorer le taux de conversion de votre boutique en ligne.

Erreur n°11 – Négliger l'importance des détails sur la page de vente

Je peux affirmer avec certitude que l'une des principales erreurs des tests A/B sur un site Web de boutique en ligne est de sous-estimer les détails de la page de vente. Il n'est pas étonnant que presque tous les détails puissent jouer un rôle décisif dans la conversion, qu'il s'agisse de la couleur d'arrière-plan, de la disposition des éléments, de la disposition des menus, du texte, de la police ou même de la longueur de la page.

✏️ Exemples

👎 Exemple de test échoué : Dans l'un des projets que j'ai supervisé, le client a uniquement modifié les couleurs d'arrière-plan des blocs principaux du site sans tester différentes options. Cela a entraîné une diminution de 15 % de la conversion globale. Nous n'avons pas pris en compte le fait que ces changements pourraient avoir un impact négatif sur la perception des textes et des images.

👍 Exemple de test réussi : Dans une autre situation, après avoir réalisé des tests A/B complexes avec modification du En améliorant simultanément la palette de couleurs et la lisibilité des polices, nous avons réussi à augmenter la conversion de 25 %. Une telle attention aux détails a justifié nos attentes et nos efforts.

Pourquoi est-ce important ?

Je suis convaincu que négliger les détails peut conduire à des erreurs colossales dans les tests A/B. Voici quelques points auxquels il faut prêter attention :

- Couleur d'arrière-plan et d'élément : Il est inacceptable de changer la palette de couleurs sans évaluer au préalable son impact sur la perception du site.

- Disposition des éléments : Il est important de noter qu'un placement incorrect des boutons ou des informations importantes peut rendre la navigation difficile pour les utilisateurs. .

- Affichage du menu : Les modifications apportées au menu sans test peuvent réduire la convivialité du site et effrayer les clients potentiels.

- Texte et polices : La lisibilité des textes et le choix correct des polices sont essentiels à l'expérience utilisateur.

- Longueur de la page : Les longues pages peuvent décourager les utilisateurs si les informations ne sont pas structurées correctement.

Mes recommandations

📊 Sur la base de mon expérience, je peux recommander les méthodes éprouvées suivantes pour la prévention des erreurs :

- Planification minutieuse des tests : Je recommande fortement les tests A/B non seulement les principaux éléments de la page, mais faites également attention aux petites choses qui peuvent affecter de manière significative la conversion.

- Approche intégrée : Pour tester différents aspects de la page de vente, il est préférable d'utiliser une approche intégrée, en testant non pas un élément à la fois, mais une combinaison de changements.

- Analyse des données reçues : Accordez toute l'attention voulue à l'analyse des résultats afin de comprendre la cause exacte le changement de conversion.

Tableau : Actions utiles et inutiles

| Action | Utile | Inutile |

|---|---|---|

| Changer la couleur d'arrière-plan | ✅ Tester les combinaisons de couleurs | ❌ Changer de couleur sans tester |

| Disposition des éléments | ✅ Évaluer l'impact par commodité | ❌ Réorganiser les éléments de manière aléatoire |

| Menu Afficher | ✅ Modifier et tester | ❌ Laisser inchangé |

| Texte et polices | ✅ Améliorer la lisibilité | ❌ Ignorer l'impact sur la perception |

| Longueur de la page | ✅ Optimiser contenu | ❌ Remplir les pages avec des données inutiles |

Je suis donc convaincu que la bonne approche des tests A/B, qui comprend l'évaluation de tous les détails, même les plus petits, de la page de vente, aidera à éviter les erreurs courantes et à améliorer considérablement les résultats de la boutique en ligne. .

Erreur n° 12 – Modification des paramètres pendant l'analyse

Dans le processus de gestion d'une boutique en ligne, j'ai rencontré à plusieurs reprises des situations où les paramètres du test A/B ont changé après son lancement, et je peux affirmer avec certitude que c'est l'un des obstacles les plus importants pour obtenir des résultats fiables. Un jour, dans le but d'optimiser l'efficacité, j'ai modifié les paramètres de test en cours de cycle. Il semblerait que de petits ajustements devraient améliorer les performances, mais c'est le contraire qui s'est produit.

🤔 Pour éviter des erreurs à l'avenir, je peux recommander quelques stratégies utiles :

📊 Évitez d'interférer avec le test s'il est déjà en cours d'exécution.

🛠️ Effectuez à l'avance tous les réglages nécessaires et vérifiez-les attentivement.

*🕰️ Attendez patiemment la fin du test, même si les résultats ne vont pas dans la direction que vous attendiez.

Lorsque j'ai modifié les paramètres de test, cela a provoqué une grave distorsion des données. Par exemple, l’introduction de nouveaux éléments sur une page a provoqué un changement dans le comportement des utilisateurs, ce qui signifie que les résultats des tests sont devenus incorrects et ne peuvent pas être utilisés pour tirer des conclusions objectives. Si j'avais attendu la fin du test, j'aurais pu y voir plus clair.

Comment éviter de telles erreurs ?

Développement et planification : Je peux vous conseiller effectuer un travail préparatoire détaillé avant le début du test. L'un de mes projets réussis consistait à créer un plan d'action étape par étape comprenant tout, des objectifs de test aux indicateurs de réussite.

Vérifiez soigneusement les paramètres : Tous les paramètres doivent être vérifié avant de commencer le test. Je fais toujours une vérification finale de tous les paramètres de chaque variation pour m'assurer qu'ils sont corrects.

Correction des paramètres : Corrige les conditions dans lesquelles le test est effectué. Cela inclut les éléments techniques, le contenu et la conception des pages, ainsi que les mesures à mesurer.

.gif)

La règle principale que j'ai développée : aucun changement pendant le test. Cela vous permettra de garder vos données propres et d'obtenir des résultats fiables.

📌 Tableau de révision

| Actions utiles | Actions à éviter | |

|---|---|---|

| Vérification approfondie des paramètres | Modification des paramètres après le démarrage | |

| Planification précise | Interférer avec un test au milieu | |

| Correction des conditions de test | Améliorations sans analyse des tests effectués |

D'après mon expérience, je recommande de toujours considérer les tests comme des expériences scientifiques. Suivez ces directives et vos tests A/B deviendront plus fiables et efficaces.

Erreur n° 13 – Absence de base de données avec les résultats des tests

L'organisation des résultats des tests A/B est un facteur fondamental pour une analyse réussie et des actions ultérieures basées sur les données. Ce n'est qu'en documentant systématiquement les performances de chaque test A/B que vous pourrez éviter les erreurs répétées et optimiser le processus. J'ai appris de ma propre expérience que l'absence d'une base de données détaillée conduit à la confusion et à des conclusions erronées.

Étude de cas

{{|2| } Sur l'un de mes projets, j'ai manqué l'importance de maintenir systématiquement une base de données de résultats de tests. La plupart des hypothèses et solutions que j'ai testées n'étaient pas correctement documentées, ce qui entraînait des tests en double et une perte de temps. Une fois, j'ai effectué un test sur une page détaillée d'un produit, dans l'espoir d'augmenter les conversions, mais les résultats n'ont pas été concluants. Ce n’est qu’après le troisième retest, lorsque j’ai enfin eu une base de données détaillée, que j’ai réalisé quelles hypothèses étaient efficaces et lesquelles ne l’étaient pas.Comment éviter cette erreur

Pour commencer, je vous recommande de maintenir une base de données structurée qui comprend :

- 📝 Informations détaillées sur les hypothèses

- 📊 Indicateurs de performance des pages testées

- 💡 Décisions qui ont apporté ou non le résultat attendu

- 📈 Volumes de croissance de divers indicateurs significatifs

Cette approche vous permet d'éviter les erreurs répétées et vous aide à évaluer les résultats des tests de manière plus objective.

Aspects importants de la maintenance d'une base de données

*Détails. Enregistrez autant d'informations que possible : dates, heures des tests, instruments utilisés, but du test et résultats obtenus.

👩💻 Automatisation. Utilisez des outils ou des plates-formes spéciales pour simplifier le processus de maintenance d'une base de données. Il peut s'agir de Google Sheets ou de solutions d'analyse spécialisées.

⏳ Mises à jour régulières. La pertinence des informations est essentielle. Mettez régulièrement à jour votre base de données au fur et à mesure que de nouveaux tests sont effectués.

🧩Structure. Assurez-vous que votre base de données est structurée logiquement et facile à lire. De cette façon, vous pouvez récupérer rapidement les informations dont vous avez besoin et prendre des décisions éclairées.

Je vous encourage à envisager de mettre en œuvre un système de gestion des résultats de tests pour utiliser plus efficacement les données collectées au profit de votre boutique en ligne.

Problèmes dus à une base de données manquante

📉Répéter les erreurs. Sans base de données, il est facile de répéter des tests échoués, ce qui non seulement fait perdre du temps, mais affecte également négativement la perception de la marque par les clients.

🤷 Pris dans des pièges. Dans certains cas, l’absence de référence peut conduire à des conclusions erronées sur ce qui fonctionne le mieux pour votre public.

🔄 Manque de progrès. Sans une analyse claire des résultats, il est impossible de construire des hypothèses correctes pour de nouvelles améliorations, ce qui freine le développement de votre entreprise.

Avantages pratiques de la maintenance d'une base de données

- 📈 Augmenter la précision des analyses

- 📋 Optimiser les ressources et le temps

- 🎯 Améliorer la qualité des hypothèses et des tests supplémentaires

- 💰 Économiser de l'argent et augmenter la rentabilité

Tableau récapitulatif

| Action | Utile | Inutile |

|---|---|---|

| Maintenir une base de données détaillée | ✅ | |

| Utiliser des outils modernes | ✅ | |

| Mise à jour de la base de données après chaque test | ✅ | |

| Négliger l'analyse des résultats | ❌ |

Je suis convaincu que la maintenance correcte d'une base de données de test serait grandement bénéfique pour votre boutique en ligne. La mise en œuvre de cette pratique vous aidera à éliminer les erreurs répétées, à rationaliser votre processus de test et, en fin de compte, à améliorer les performances financières de votre entreprise.

Erreur n°12 – Focus sur une page : pourquoi éviter ?

J'ai remarqué que de nombreux propriétaires de boutiques en ligne font souvent la même erreur : rester bloqués à tester une page, essayant de l'améliorer sans cesse. Cela peut paraître logique, car en améliorant la page clé, vous pouvez supposer que les conversions vont augmenter. Mais je peux affirmer avec certitude que ce n’est pas toujours le cas.

Exemple tiré de mon expérience

À titre d'exemple, j'ai travaillé avec un magasin d'électronique en ligne qui concentrait tous ses efforts sur l'optimisation de la page d'accueil. Nous avons effectué plusieurs séries de tests A/B, amélioré la conception, ajouté de nouveaux CTA et modifié le texte. Les résultats ont été initialement encourageants, mais nous avons ensuite constaté des rendements décroissants : de nouveaux changements n'ont apporté que des gains minimes en termes de conversions.

🤔 J'ai décidé de changer de stratégie et j'ai suggéré au client de tester un autre domaine important : la page du panier. Et les résultats étaient tout simplement incroyables. L'optimisation de la page du panier a produit une augmentation des conversions plus importante que toutes les modifications précédentes apportées à la page d'accueil. Nous avons amélioré la navigation, simplifié le processus de commande, ajouté une option de paiement rapide – et les conversions ont augmenté de 30 % !

Pourquoi cela se produit-il ?

📉 Se concentrer sur une seule page conduit à ce que l'on appelle le « plafond », après quoi d'autres améliorations n'apportent presque aucun résultat. Je recommande fortement de prêter attention aux autres pages de votre site qui sont également importantes pour la chaîne de conversion.

Comment éviter cette erreur

🔍 Tout d'abord, vous devez effectuer une analyse complète de toutes les étapes du parcours utilisateur. Déterminez sur quelles pages vos clients potentiels sont les plus susceptibles d'interrompre le processus d'achat.

🛠️ Je vous conseille de faire attention aux domaines suivants :

- ✨ Page Produit

- 💼 Page de catégorie de produit

- 🛒 Page de panier

- 🧾 Ordre des pages de paiement

Conseil d'optimisation

Chaque fois que j'envisage d'améliorer différentes zones d'un site, je suis une stratégie éprouvée :

- Analyse des données : je commence toujours par analyser les métriques des utilisateurs et les données comportementales.

- Hypothèse : Sur la base de l'analyse, je formule plusieurs hypothèses à tester.

- Exécution de tests : exécution de tests A/B pour déterminer quels changements entraînent réellement une augmentation des conversions.

Si à un moment donné, il semble que l'amélioration d'une page n'apporte pas les résultats escomptés, c'est un signal certain qu'il est temps de passer à une autre zone du site.

Résumé

📊 Dans le tableau ci-dessous, je veux montrer ce qui vaut et ce que ne vaut pas la peine de le faire pendant les tests A/B :

| Que faire 🟢 | Ce qu'il ne faut pas faire 🔴 |

|---|---|

| Analyser l'intégralité du parcours utilisateur | Boucle sur une page |

| Tester différentes zones du site | Ignorer les pages à faible conversion |

| Utiliser des données pour formuler des hypothèses | Apporter des modifications sans analyse |

Je vous encourage donc à examiner l'intégralité du parcours d'achat sur votre site Web et à rechercher des moyens de vous améliorer à chaque étape. Cela vous aidera vous obtenez des résultats beaucoup plus significatifs.

Erreur n° 15 – N'appliquez pas d'idées réussies à d'autres pages sans tests supplémentaires

Souvent, lors du processus de test A/B, des solutions très efficaces sont découvertes sur une page de boutique en ligne. Je me souviens d'un moment dans l'un de mes projets où nous avons effectué des tests fractionnés pour améliorer le titre de la page, ce qui a entraîné une augmentation significative des conversions. 🌟

Sur cette page, le changement de titre a finalement apporté +18% au ventes totales Le succès de ce test nous a incité à appliquer la même idée à d'autres pages du site. Mais il est important de garder à l’esprit un détail essentiel : ce qui fonctionne sur une page ne sera pas nécessairement aussi efficace sur une autre.

En prenant notre équipe comme exemple : après avoir installé le même en-tête sur d'autres pages du site, nous avons constaté que les conversions non seulement n'augmentaient pas, mais diminuaient également légèrement sur certaines pages. . La raison en est, à mon avis, les différences de contexte et de contenu sur ces pages.

Voici quelques recommandations que j'aimerais vous proposer en fonction de mon expérience :

- 🚀 Il est nécessaire de faire des tests supplémentaires. Même si une idée semble brillante et s'est avérée efficace sur une page, cela ne signifie pas qu'elle peut être automatiquement transférée sur toutes les autres pages sans test.

- 🔔 Considérez les spécificités de chaque page. En tant que spécialiste faisant autorité dans ce domaine, je peux le dire en toute confiance : chaque page a sa propre audience et sa spécificité. Ce qui fonctionne pour un groupe cible ne fonctionnera pas nécessairement pour un autre.

- 💡 Créez des hypothèses pour chaque page. Au lieu de copier aveuglément une solution réussie, je suggère de formuler des hypothèses pour chaque page individuelle et de les tester sur place. Cela vous permettra d'éviter les situations de baisse des conversions et de trouver des solutions optimales pour chaque page.

À en juger par ma pratique, je suis tombé dans ce piège à plusieurs reprises : transférer des idées réussies sans tests supplémentaires, mais maintenant, je fais ça beaucoup moins souvent.

Tableau de présentation des meilleures pratiques

| Pratique | Utile | Pas utile |

|---|---|---|

| Tester des idées réussies sur d'autres pages | ✅ Augmente les chances de succès | ❌ Risque de chute des conversions sans tests |

| Prendre en compte les spécificités des pages | ✅ Approche individuelle | ❌ Ignorer les expériences étonnantes |

| Création et test d'hypothèses | ✅ Augmentation de la précision | ❌ Temps perdu sans confirmations |

Ainsi, en appliquant mes conseils et mes approches, les propriétaires de boutiques en ligne et les spécialistes du marketing seront en mesure d'utiliser les tests A/B plus efficacement, évitant ainsi les erreurs courantes dans leur travail. Je recommande fortement de prêter attention aux aspects ci-dessus pour garantir que vos efforts aboutissent à des résultats vraiment tangibles.

Erreur n°16 – Ne pas diviser les résultats en segments

L'une des erreurs clés que j'ai remarquées à plusieurs reprises dans ma pratique est d'ignorer la segmentation des données reçues lors de la réalisation de tests A/B. Lorsque les résultats des tests sont regroupés sans tenir compte des différences entre les segments, de nombreuses nuances importantes peuvent être perdues, conduisant finalement à des conclusions erronées et donc à des décisions inefficaces.

Exemple de situation réelle

Permettez-moi de partager un de mes exemples. Dans l'un des projets de boutique en ligne, nous avons testé une modification du design de la page produit. Le changement a été un succès, montrant une augmentation de 30 % des taux de conversion pour les utilisateurs mobiles. Cependant, si nous n'avions pas segmenté les données et simplement les avoir analysées de manière globale avec les utilisateurs d'ordinateurs de bureau, nous aurions peut-être manqué le fait que le changement n'a pas eu un impact aussi significatif sur les ordinateurs de bureau.

📝 Points clés à considérer :

- Différents appareils utilisateur : L'expérience utilisateur varie considérablement en fonction de l'appareil. 📱💻

- Canaux d'acquisition : Les canaux de trafic, qu'il s'agisse de recherche organique, de réseaux sociaux ou de publicité payante, peuvent également influencer sur les résultats des tests. 🌐

- Segments géographiques : La géographie des utilisateurs peut également jouer un rôle important. 🌍

Pourquoi la segmentation est-elle importante ?

Je pense que des données correctement segmentées permettent de mieux comprendre la manière dont les différents utilisateurs réagissent au changement. Cela vous permet de personnaliser les approches et d'améliorer l'efficacité des tests pour chaque segment.

Une segmentation appropriée des données permet d'éviter de fausses conclusions et permet une compréhension précise des réalités.

Directives de segmentation {{|104| }

🔍 Voici quelques éléments auxquels je recommande de prêter attention lorsque vous travaillez avec la segmentation :

- Appareils : Analysez les données sur différents appareils : mobile, ordinateur de bureau et tablette.

- Sources de trafic : Segmentez vos données par sources de trafic : SEO, PPC, réseaux sociaux et autres.

- Géographie : Examinez les données de différents pays ou régions.

- Heure de la journée : Surtout si votre boutique en ligne a une portée mondiale, la diviser par fuseau horaire peut être utile.

🎯 Conseils pour éviter les erreurs :

- Utilisez des outils d'analyse qui facilitent la segmentation de vos données

- Examinez régulièrement les segments et ajustez-les si nécessaire

- Testez les changements de manière large et représentative. échantillons pour chaque groupe

Revue des bonnes et mauvaises pratiques

| Pratiques utiles | Pratiques indésirables |

|---|---|

| Segmenter les données par appareil | Fusionner toutes les données en un seul groupe |

| Analyser les résultats par sources de trafic | Ignorer les canaux d'acquisition |

| Considérer les segments géographiques | Négliger les différences régionales |

| Réviser les segments si nécessaire | Réparez les segments une fois pour toutes |

Donc, je peux dire avec confiance que la prise en compte des données de segmentation lors du test A/B d'une boutique en ligne vous permet d'obtenir des résultats plus précis et plus utiles. Je vous encourage à considérer l’importance de cette pratique pour réussir vos campagnes marketing.

Erreur n°17 - Correction des erreurs lors du rejet d'une hypothèse sans vérifier les versions supplémentaires

Je souhaite partager une leçon importante que j'ai apprise en effectuant des tests A/B pour la boutique en ligne que je gérais. Il arrive souvent que l'hypothèse formulée échoue sur la base des résultats des tests. Cependant, j’ai réalisé que cela ne signifie pas toujours que l’hypothèse était fausse. Le problème résidait souvent dans le choix de l’option de mise en œuvre.

Exemples de tests échoués et réussis

🚀 Tests échoués :

Lorsque j'ai testé la modification de la couleur du bouton CTA, la version originale rouge vif fonctionnait mal. J'aurais pu abandonner immédiatement cette hypothèse, mais j'ai décidé d'essayer d'autres teintes.

Une autre fois, j'ai testé de remplacer l'image principale par une image plus émotionnelle. Le premier résultat a été décevant, mais plutôt que de rejeter complètement l’idée, j’ai essayé une image différente avec un texte plus approprié. Cela s’est traduit par une amélioration significative des taux de conversion.

🌟 Tests réussis :

Dans l'un des tests, j'ai décidé de modifier la disposition des éléments sur la page. La première mise en page n'a pas produit les résultats escomptés, mais en modifiant la mise en page, j'ai trouvé un formulaire plus efficace qui augmentait le temps passé par les utilisateurs sur le site.

Lors du test d'une nouvelle forme de bouton CTA, la version originale avait l'air mauvaise, mais après l'avoir remplacée par une forme plus grande et Plus contrasté, j'ai remarqué une augmentation significative des taux de clics.

Impact des erreurs sur les résultats

Je suis sûr qu'abandonner une hypothèse sans tester des versions supplémentaires peut entraîner des opportunités manquées. Plusieurs fois, j'ai perdu le potentiel d'augmentation des conversions et de la satisfaction des utilisateurs en tirant des conclusions hâtives. Si j'avais réalisé plus tôt l'importance de vérifier d'autres options, j'aurais pu éviter de nombreuses erreurs.

Techniques de prévention des erreurs

Je vous recommande vivement :

📝 Essayez différentes formes :

- Utilisez des images et des textes différents.

- Modifier la mise en page.

- Expérimentez l'apparence des boutons CTA (couleur, taille, texte).

📊 Analysez les résultats de chaque option :

- Portez une attention particulière aux métriques.

- Comparez les résultats de chaque changement.

🔍 Jetez un œil plus large :

- Je conseille de considérer le contexte et les circonstances.

- Il est important de tirer des conclusions basées sur plusieurs tests.

Je suis convaincu que l'application de ces méthodes vous permettra d'éviter les erreurs courantes et d'obtenir de meilleurs résultats dans les tests A/B.

Tableaux : actions utiles et inutiles

| Actions utiles | Actions inutiles |

|---|---|

| Essayez différentes implémentations | Rejetez l'hypothèse après le premier test |

| Analyser chaque version | Ignorer les résultats des tests A/B |

| Tenir compte du contexte et des circonstances | Tirer des conclusions basées sur un test |

Bonnes pratiques :

- Préparation approfondie des hypothèses : J'essaie toujours d'analyser en profondeur les problèmes et les opportunités actuels.

- Test de différentes versions de : il est important de tester plusieurs implémentations.

- Travail d'équipe : impliquer des collègues dans la discussion des résultats permet d'éviter la subjectivité.

C'est cette approche qui m'a permis d'obtenir des résultats élevés et de devenir un expert dans le domaine des tests A/B pour les boutiques en ligne. Je vous encourage à suivre ces conseils et à progresser en toute confiance vers le succès !

Erreur n°18 – Rechercher de grands changements

Dans ma pratique, j'ai identifié une erreur courante que beaucoup commettent, y compris moi au début de ma carrière : le désir de mettre en œuvre immédiatement des changements à grande échelle. À première vue, cela semble logique : plus les changements sont importants, plus l’augmentation de la conversion et des autres KPI peut être importante. Cependant, je suis devenu convaincu que l’approche nécessitait une révision en profondeur.

Mon expérience : comment la mise en œuvre de changements importants a conduit à l'échec

Lorsque j'ai utilisé pour la première fois les tests A/B sur l'une de mes premières plateformes en ligne, j'étais plein d'enthousiasme et j'ai apporté des changements radicaux à la conception du site. Cependant, les résultats n’étaient pas du tout ceux que j’attendais. Au lieu d'une forte augmentation des conversions, j'ai remarqué une diminution des indicateurs clés et un nombre important de retours négatifs de la part des utilisateurs. Cela m’a appris une leçon sur l’importance d’un changement progressif.

Pourquoi les changements à grande échelle échouent souvent

- 🛠️ Imprévisibilité des performances : Les changements radicaux peuvent être trop risqués car leur impact est difficile à prévoir. Parfois, même de petits changements dans la conception ou la fonctionnalité entraînent des conséquences négatives.

- 💵 Augmentation des coûts : Les changements à grande échelle nécessitent des ressources financières et temporelles importantes, ce qui entraîne des coûts supplémentaires et d'éventuelles pertes.

- 🤔 Problèmes de perception des utilisateurs : Les utilisateurs sont habitués à une certaine interface et fonctionnalité. Des changements brusques peuvent provoquer du mécontentement et une perte de clientèle.

Exemple d'approche réussie : ajustements incrémentaux

Sur l'un des projets sur lesquels j'ai travaillé le , nous avons décidé de renoncer aux changements radicaux et de nous concentrer sur de petites améliorations progressives. La mise en œuvre d'ajustements progressifs, tels que la modification des couleurs des boutons, l'amélioration de la navigation et l'optimisation des pages de destination, ont apporté des résultats positifs vraiment significatifs. La conversion a commencé à augmenter progressivement et les avis positifs des utilisateurs ont confirmé l'exactitude de la stratégie choisie.

Recommandations pour la mise en œuvre de petits changements

🔍 Analyse des données : L'analyse régulière des données statistiques vous permet d'identifier des domaines spécifiques nécessitant de petites améliorations.

🖍 Ajustements incrémentiels : Je recommande fortement de commencer petit, en testant chaque changement indépendamment. Cela contribuera à minimiser les risques et à réduire les coûts.

📊 Approche itérative : En introduisant des changements de manière itérative, vous pouvez mieux suivre leur impact sur des indicateurs importants et ajuster votre stratégie. en conséquence des résultats obtenus.

Mon expérience et mes recommandations

J'ai vu que la distribution rationnelle des changements peut apporter des améliorations tangibles sans mettre les utilisateurs dans une situation de stress. Je vous recommande d'éviter de pousser à de grands changements et de vous concentrer sur de petits ajustements incrémentiels. Je suis convaincu que cette approche conduira à des résultats plus stables et positifs.

N'oubliez pas : De petits changements peuvent s'additionner et conduire à de grandes améliorations dans les grands image.

| Utile | Inutile |

|---|---|

| Ajustements progressifs | Changements radicaux |

| Analyse régulière des données | Refonte en profondeur sans test |

| Petits tests changes | Tests superficiels de changements importants |

Les efforts d'amélioration progressifs permettent d'obtenir des résultats positifs constants. Je conseillerais à d'utiliser cette approche pour minimiser les risques et optimiser l'expérience utilisateur.

Je suis convaincu que la mise en œuvre de petits changements vous fournira des résultats positifs et des commentaires positifs de la part des utilisateurs.

Conclusion : principales erreurs lors des tests A/B sur un site Web de boutique en ligne

Erreur 1 : Ne pas se préparer suffisamment pour les tests

L'un des aspects les plus importants d'un test A/B réussi est une préparation minutieuse. J'ai appris par expérience personnelle que l'administration de tests sans préparation adéquate peut conduire à des résultats faussés et à une perte de temps. Par exemple, dans l'un de mes projets, des objectifs et des hypothèses de test clairs n'étaient pas définis. Cela a conduit au fait que les résultats n'étaient pas informatifs et ne nous ont pas permis de tirer des conclusions claires.

Comment éviter :

- 📌 Je vous recommande fortement de définir des objectifs et des hypothèses clairs avant de commencer les tests.

- 📌 Évaluez les performances actuelles et effectuez une analyse préliminaire des données pour définir correctement les groupes de contrôle et de test.

Erreur 2 : Mauvais choix de métriques

Un de mes projets a échoué parce que nous nous sommes concentrés sur des mesures qui n'avaient pas beaucoup d'importance pour les résultats. Nous avons uniquement mesuré le CTR et le temps passé sur le site, au lieu de nous concentrer sur la conversion et la valeur moyenne des commandes.

Comment éviter :

- 👓 Je recommande de prêter attention aux indicateurs de performance clés (KPI) qui comptent le plus pour votre entreprise.

- 👓 Développez un système de métriques qui vous aidera à comprendre l'impact réel des changements.

Erreur 3 : taille d'échantillon insuffisante

Une fois, j'ai effectué un test sans m'assurer que la taille de l'échantillon était suffisante. Cela a abouti à des résultats statistiquement peu fiables et qui n’ont pas pu être utilisés pour prendre des décisions éclairées.

Comment éviter :

- 📊 Je recommanderais de faire des calculs préliminaires de la taille de l'échantillon à l'aide de calculatrices spéciales.

- 📊 Attendez la fin du test jusqu'à ce qu'il y ait suffisamment de données pour produire des résultats statistiquement significatifs.

Erreur 4 : ignorer la saisonnalité et d'autres facteurs externes

Dans un cas, nous avons exécuté A /B à la veille d'un jour férié important, ce qui a sérieusement faussé les résultats en raison d'une forte augmentation du trafic. Ignorer ainsi les facteurs saisonniers était une grave erreur.

Comment éviter :

- 🎯 Je vous conseille de prendre en compte tous les facteurs saisonniers et externes lors de la planification des tests.

- 🎯 Testez pendant des périodes stables pour minimiser l'impact des événements externes.

« Il vaut mieux passer plus de temps à préparer et à planifier que de corriger des erreurs et d'obtenir des données inexactes », article Forbes.

Exemple pratique et recommandations

Dans l'un de mes projets, nous avons testé la modification de la palette de couleurs. d'un bouton "Acheter". Dès les premières étapes des tests, nous avons remarqué que les taux de conversion se sont améliorés pour le groupe doté du nouveau bouton. Mais lorsque nous avons augmenté la taille de l’échantillon et pris en compte les facteurs saisonniers, les résultats ont changé dans la direction opposée. Cela nous a permis d'éviter une décision erronée qui aurait entraîné des pertes.

Résumé :

🟢 Mieux vaut faire :

- Préparez soigneusement les tests.

- Choisissez les bonnes métriques.

- Assurez-vous d'avoir une taille d'échantillon suffisante.

- Tenir compte des facteurs saisonniers et externes.

🔴 Ne faites pas :

- Exécuter des tests sans préparation.

- Concentrez-vous sur les métriques secondaires.

- Travaillez avec des données insuffisantes.

- Ignorez l'influence des facteurs externes.

🛠️ Sur la base de cette expérience, je recommande fortement de suivre les méthodes et approches ci-dessus pour obtenir des données précises et précieuses.

Expérience company prom.ua

Company prom.ua est l'une des plus grandes boutiques en ligne d'Ukraine, offrant une large gamme de produits de différents vendeurs. L'objectif principal de l'entreprise est de fournir un processus d'achat pratique et fiable aux utilisateurs, tout en garantissant des taux de conversion élevés à ses vendeurs.

Objectifs du projet :

- Augmenter la conversion du site Web

- Optimiser l'expérience utilisateur

- Augmentation du contrôle moyen

- Diminution du taux de rebond

Problème principal : L'entreprise était confrontée au problème d'une faible conversion et de taux de rebond élevés sur les pages clés du site. Il a été décidé de réaliser des A/B tests pour trouver les meilleures solutions pour améliorer ces indicateurs.

Public cible : Public principal prom.ua sont des internautes actifs âgés de 25 à 45 ans qui préfèrent faire leurs achats en ligne. Ces utilisateurs apprécient la commodité, la rapidité et un large choix de produits.

Principaux intérêts des utilisateurs :

- Navigation pratique sur le site 🧭

- Chargement rapide des pages ⏱️

- Descriptions de produits claires et détaillées 📋

- Recherche et filtrage faciles des produits 🔍

- Méthodes de paiement et de livraison fiables 💳

Exemples de tests réussis et infructueux

Test réussi : L'un des tests les plus réussis était une expérience visant à modifier la structure des cartes alimentaires. L'hypothèse de était qu'augmenter la taille des images de produits et ajouter un bouton Aperçu rapide améliorerait l'expérience utilisateur et augmenterait les conversions.

résultats :

- Augmentation des conversions de 18 %

- Réduire les taux de rebond de 12 %

- Augmentation du contrôle moyen de 5 %

Caractéristiques du test :

- Segment de clientèle : utilisateurs âgés de 25 à 45 ans

- Période de test : 4 semaines

- Méthode d'analyse : signification statistique basée sur les données de Google Analytics

Test échoué : l'un des tests les moins réussis consistait à modifier la palette de couleurs de le panier d'ajout de boutons. Hypothèse : Remplacer les boutons verts par des boutons rouges attirera plus d'attention et augmentera l'engagement.

résultats :

- Le taux de conversion baisse de 5 %

- Avis négatifs des utilisateurs sur le nouveau design

Caractéristiques des tests :

- Segment client : tous les visiteurs du site

- Période de test : 2 semaines

- Méthode d'analyse : enquêtes auprès des utilisateurs et données Google Analytics

Conclusions et recommandations

Les erreurs commises lors des tests affectent directement les résultats et peuvent conduire à l'effet inverse. L'erreur la plus critique rencontrée par prom.ua était associée à une période de test insuffisante.

Recommandations :

- Testez régulièrement 🗓️ pour travailler constamment à l'amélioration du site.

- Prolongez les périodes de test pour obtenir des données statistiquement significatives.

- Créez hypothèses claires 📊 avant de commencer le test.

- Concentrez-vous sur la fonctionnalité 💻, pas seulement sur le design.

- Analysez vos données plus en profondeur 📉 pour ne pas manquer de détails importants.

Devis client

"La réalisation de tests A/B réguliers et soigneusement planifiés nous a aidés à améliorer considérablement les indicateurs clés de conversion et de satisfaction client." — Stanislav Loginov, représentant de la société prom.ua

Ces conclusions et recommandations vous aideront à éviter les erreurs courantes et à faire des tests A/B un outil plus efficace pour améliorer votre boutique en ligne.

Questions fréquemment posées sur le sujet : Les principales erreurs des tests A/B sur un site de boutique en ligne et comment pour les éviter

1. Pourquoi ne devriez-vous pas abandonner complètement les tests fractionnés ou les effectuer de manière irrégulière ?

Les tests fractionnés vous aident à identifier les changements les plus efficaces pour augmenter les conversions et améliorer l'expérience utilisateur. Sans eux, les décisions sont prises sur la base d’hypothèses, ce qui conduit souvent à des résultats inefficaces.

2. Dans quelle mesure une courte période de test est-elle critique ?